Samenwerkende wetenschappers van de TU Eindhoven en de Arizona State University hebben een techniek ontwikkeld waarmee aanzienlijk kleinere lasers kunnen worden gemaakt dan tot op heden mogelijk was.

De algemeen geaccepteerde grens voor de afmetingen van een laser is de halve golflengte van het geproduceerde licht. Bij halfgeleiderlasers moet er nog een correctiefactor worden toegepast die afhankelijk is van de refractie-index van de halfgeleider. In de praktijk heeft deze factor een waarde van drie, wat betekent dat een laser die licht van 1500nm produceert, een minimale afmeting van 750/3 oftewel 250nm heeft.

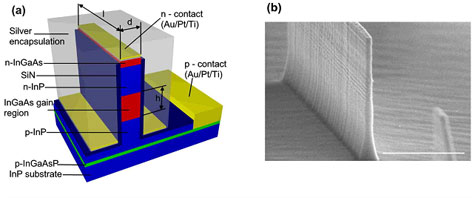

De onderzoekers van de TU/e en de ASU zijn er echter in geslaagd de minimum afmetingen van halfgeleiderlasers te halveren. Zij voorzagen daartoe een laagje halfgeleidermateriaal van 80nm dik van twee isolerende lagen van 20nm. Die gelaagde structuur werd vervolgens weer ingesloten tussen twee zilveren lagen. De hiermee geconstrueerde laser werkt alleen bij cryogene temperaturen, maar de wetenschappers onderzoeken of het mogelijk is om een bij kamertemperatuur werkend exemplaar te maken.

De ontwikkeling zou moeten bijdragen aan het gebruik van lasers in een veld dat nanophotonics genoemd wordt. De lasers zouden onder meer toegepast kunnen worden als optisch communicatiemiddel binnen processors en voor medische applicaties.

/i/1274010398.png?f=fpa)

/i/1274012436.png?f=fpa)

/i/1207149874.png?f=fpa)

/i/1245595122.png?f=fpa)

/i/1260865964.png?f=fpa)

:strip_exif()/i/1152627031.gif?f=fpa)

/i/1198048718.png?f=fpa)