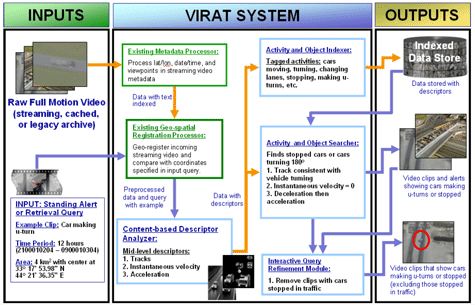

Darpa ontwikkelt een realtime herkennings- en indexeringssysteem voor video. De uiteindelijke doelstelling voor het Virat-systeem is om duizenden uren videomateriaal binnen enkele minuten te kunnen doorzoeken.

De Amerikaanse defensieorganisatie Darpa wil de ontwikkeling van Virat in drie fases uitvoeren. De eerste fase is gereserveerd voor de ontwikkeling van de algoritmes en ontwerp van het systeem, in de tweede fase worden de algoritmes verfijnd en worden voorstellen gedaan voor systeemintegratie en in de laatste fase zal Virat zich echt moeten bewijzen. Darpa heeft de opdracht van 6,7 miljoen dollar voor de eerste fase toegekend aan Kitware, dat hiervoor zijn Vibrant-systeem heeft voorgesteld. Naast Kitware hebben ook BAE Systems National Security Solution en Lockeed Martin een opdracht voor Virat ontvangen. Deze zullen waarschijnlijk de latere fases voor hun rekening nemen.

Het Amerikaanse leger maakt voor huidige militaire operaties al gebruik van videobeelden die vanuit de lucht gemaakt worden, maar het analyseren ervan is een kostbaar en tijdrovend proces: meerdere analisten krijgen elk een afzonderlijk deel van een videostream voorgeschoteld, dat ze moeten doorzoeken op een specifiek aantal verschijnselen. Vanwege het tijdrovende aspect van deze onderzoeksmethoden worden videoarchieven nu al zelden onderzocht, terwijl dit toch interessante informatie op kan leveren. Bovendien is er nu al een tekort aan gespecialiseerd personeel, en toekomstige video-observatiesystemen zullen volgens Darpa gebieden tot meer dan 25 vierkante kilometer bestrijken.

Virat moet volgens Darpa in staat zijn om onder meer te herkennen of een persoon loopt of rent, welke gebaren hij maakt, of hij aan het graven is of dat een voorwerp wordt opgepakt. Ook interacties tussen personen onderling, zoals ontmoetingen, het voortbewegen in groepen en het schudden van handen, moeten door het systeem gedetecteerd kunnen worden. Daarnaast moet Virat bijvoorbeeld kunnen opmerken wanneer een persoon een gebouw binnengaat, in een auto stapt of een auto inlaadt, en of een auto versnelt of keert.

De videobeelden zullen vooral afkomstig zijn van bemande of onbemande observatievliegtuigen. Virat zal daarom rekening moeten houden met de resolutie en het type - zichtbaar of infrarood licht - van de beeldsensor, de snelheid en de hoogte van het observatieplatform, en de weersomstandigheden.

:strip_exif()/i/1098602434.jpg?f=fpa)

/i/1297957796.png?f=fpa)

/i/1261129404.png?f=fpa)

:strip_exif()/i/1034032919.jpg?f=fpa)

/i/1168530025.png?f=fpa)

/i/1242812802.png?f=fpa)

/i/1218566851.png?f=fpa)