Op de ISSCC heeft Suns Marc Tremblay de grote lijnen van het ontwerp van de Rock-processor bekendgemaakt. Threads spelen in de zestien processorkernen van de Rock 'haasje-over'.

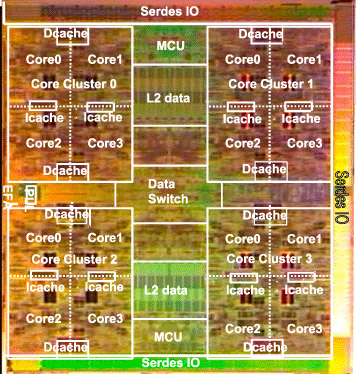

Sun heeft zijn Rock-processor op een unieke manier ingericht. De chip is opgebouwd uit vier clusters met in elke cluster vier processorkernen, en elke cluster deelt een instructiecache, twee floating-pointeenheden en twee datacaches. Iedere processorkern kan vier instructies tegelijk verwerken, heeft een oppervlakte van 14 vierkante milimeter en verbruikt 10W. In totaal zal de Rock-processor een vermogen opnemen van 250W. De kloksnelheid van Rock komt uit op 2,3GHz en daarmee zal de chip per thread beduidend sneller zijn dan de Niagara-multiprocessors.

Courante serverprocessors maken meestal gebruik van out-of-order-executie van instructies en branch prediction, zodat de trage aanvoer van data uit het geheugen de processor niet lamlegt. Volgens Sun moet hiervoor te veel ruimte op de chip gereserveerd worden. Bij de Rock-processor is alleen het laatste gedeelte van het uitvoergedeelte van de processor out-of-order.

Threads spelen bij Rock 'haasje-over'. Als een draadje te lang moet wachten op data uit het hoofdgeheugen, wordt de status van de thread opgeslagen in een 'checkpoint' en wordt een 'scout thread' aangemaakt. Deze snelt vooruit totdat het resultaat in het register van de processor kan worden weggeschreven of de informatie wordt in een wachtrij geplaatst. De wachtrij heeft 128 posities en maakt gebruik van energiezuinig sram. Als de originele thread weer data krijgt, volgt deze het verkenningsdraadje. Als de scout wordt opgehouden en ingehaald door de hoofddraad, wisselen ze van functie. In principe wordt een thread dus twee keer uitgevoerd. Per thread zijn acht checkpoints mogelijk. De scout is onzichtbaar voor het besturingssysteem en moet daardoor in principe zonder al te veel aanpassingen bestaande Solaris-code kunnen draaien.

Het ontwerp van de Rock doet denken aan Suns MAJC-javaprocessor en aan het concept van de 'slipstream processors' van de universiteit van North Carolina.

/i/1245158199.png?f=fpa)

/i/1241164523.png?f=fpa)

:strip_exif()/i/1186150602.jpg?f=fpa)