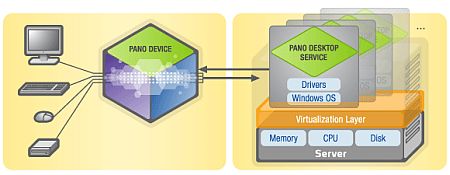

Pano Logic brengt een klein hardwarematig virtualisatieapparaat op de markt, dat is ontworpen om de desktop-pc te vervangen. De gadget heeft geen cpu en geen geheugen en draait zelf geen besturingsysteem.

De Pano verbindt toetsenbord, monitor en usb-apparatuur via het netwerk met een gevirtualiseerde versie van Windows Vista of XP die op een server draait. Bedrijven die het apparaat gebruiken kunnen de kosten voor desktops met zeventig procent terugbrengen en het beveiligingsrisico verkleinen dat dergelijke systemen met zich meebrengen, zo beweert Pano Logic.

De Pano verbindt toetsenbord, monitor en usb-apparatuur via het netwerk met een gevirtualiseerde versie van Windows Vista of XP die op een server draait. Bedrijven die het apparaat gebruiken kunnen de kosten voor desktops met zeventig procent terugbrengen en het beveiligingsrisico verkleinen dat dergelijke systemen met zich meebrengen, zo beweert Pano Logic.

In tegenstelling tot veel andere thin clients bevat de Pano geen drivers of andere software waardoor er geen kans op infectie met malware zou zijn. Het bedrijf weigert overigens over een thin client te spreken omdat de Pano een volledige Windows-versie voorschotelt, waar normale thin clients een server met elkaar delen. Het apparaatje werkt in combinatie met VMware Server; en kan in een bestaande VMware-configuratie worden geïmplementeerd. De virtualisatiegadget bevat drie usb-aansluitingen, een vga-uitgang en een ethernet-aansluiting. In de Pano bevindt zich een chip die de virtualisatie beheert. Volgens Pano Logic verbruikt hun product slechts 5 watt, aanzienlijk minder dan de gemiddelde desktop-pc. Het bedrijf vraagt twintig dollar per maand voor een licentie op een Pano. Het betreft hier overigens niet de eerste hardwarematige thin client: Sun biedt met het Sun Ray-systeem bijvoorbeeld vergelijkbare functionaliteit, al beschikken zulke terminals wel over onder andere een eigen processor.

/i/1295354481.png?f=fpa)