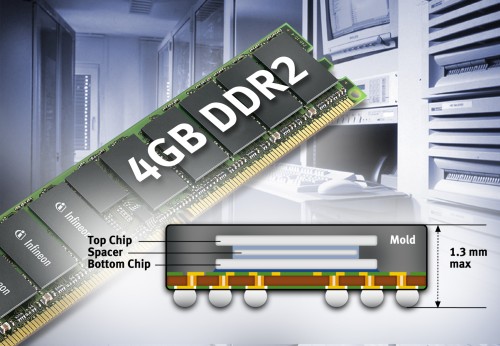

Infineon heeft een DDR2-geheugenmodule ten toon gesteld met een capaciteit van 4GB die gebruik maakt van dual-die geheugenchips. In plaats van één die, bevatten dual-die geheugenchips twee die's, waardoor de capaciteit effectief verdubbeld wordt. Hoewel het idee simpel is, is de uitvoering ervan een stuk moeilijker. Dit komt doordat de behuizing volgens de door JEDEC opgestelde specificaties voor DDR2-geheugenchips maar een maximale dikte mag hebben. Naar eigen zeggen, is Infineon de eerste die erin geslaagd is om twee die's in een behuizing onder te brengen, zonder dat de behuizing te dik wordt.