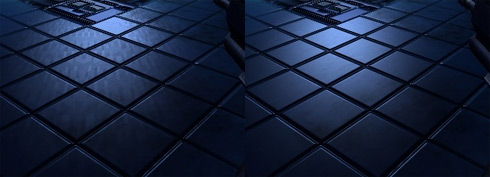

Op het forum van DriverHeaven.net zijn Farcry benchmark resultaten gepost waarin wordt gekeken naar de prestaties van de GeForce 6800 Ultra wanneer Farcry gefopt wordt en ten onrechte denkt dat er een Radeon 9800 aanwezig is in het systeem. Het blijkt dat dit een flinke invloed heeft op de prestaties. Wanneer de GeForce 6800 Ultra met zijn eigen DeviceID door de benchmark wordt gehaald scoort de kaart bijna vijftig procent boven de Radeon 9800 XT. Wanneer de GeForce 6800 Ultra echter met het DeviceID van een Radeon 9800 wordt opgezadeld verdwijnt het verschil grotendeels. Wat overblijft is een voorsprong van ruim vijftien procent voor de GeForce 6800 Ultra ten opzichte van de Radeon 9800 XT.

De oorzaak van dit verschil wordt veroorzaakt doordat de GeForce 6800 Ultra gebruikmaakt van een ander render path dan de Radeon 9800 XT. Volgens de auteur van de resultaten gebruikt Farcry voor de GeForce 6800 Ultra hetzelfde render path als voor de GeForce FX-serie. Dit render path onderscheidt zich van het Radeon 9800-path door het gebruik van meer versie 1.1- in plaats van versie 2.0-shaders en 16-bits precisie in plaats van 24/32-bits precisie. Het gevolg hiervan is logischerwijs een lagere beeldkwaliteit en, zoals de benchmarks hebben laten zien, een flink voordeel qua performance. Zowel nVidia als de developers van Farcry hebben nog niet gereageerd op de resultaten.