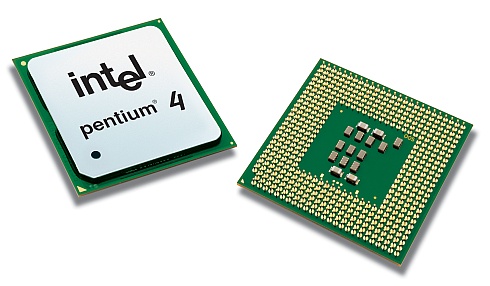

Bij Accelenation.com is een artikel verschenen waarin de HyperThreading-prestaties van de Pentium 4E Prescott-processor worden onderzocht. Bij de introductie van HyperThreading met de 3,06GHz Northwood bleek de techniek goed voor een prestatieverbetering van circa 5 procent in SMP-applicaties. Men veronderstelde dat de prestaties verder toe zouden kunnen nemen wanneer de processor de beschikking zou krijgen over meer cachegeheugen. De Prescott heeft tweemaal zoveel cachegeheugen als de Northwood en daarnaast zijn verschillende optimalisaties doorgevoerd wat betreft de HyperThreading-functionaliteit.

Na een serie benchmarks blijkt dat deze twee veranderingen inderdaad een positief resultaat hebben geboekt. De Prescott blijkt gemiddeld genomen een extra vier procent sneller te zijn met HyperThreading ingeschakeld dan de Northwood. In de toekomst zal dit verschil waarschijnlijk verder toenemen. In de SSE3-instructieset zitten namelijk een tweetal instructies die speciaal bedoeld zijn om de HyperThreading-prestaties te verbeteren:

There are some things benchmarks can't tell yet. Since Prescott is a relatively new product, there haven't been any programs that are optimized for its instructions. When SSE3 is adopted by more applications, we should see more improvements in Hyper-Threading performance, as SSE3 contains 2 new instructions to improve HT. While benchmarks give a rough idea of how well Hyper-Threading performs, there are still some things that it can't tell us. Hyper-Threading benefits multitasking and there's no true benchmark to measure that.