--------------------------------------------------

Ik wil daar wel een beetje tegen in gaan.

AMD heeft niet echt goede prijzen voor consumenten die graag de nieuwste toeters en bellen aan willen zetten als ze geld uitgeven aan een nieuwe GPU (en geef ze eens ongelijlk)

--------------------------------------------------

Heb je het dan over RDNA4 vs Blackwell of over RDNA3 vs ADA?

In beide gevallen heeft AMD volgens mij een prima prijs verhouding gehad. 7900XTX was 20% goedkoper dan een 4080 en had 8GB extra geheugen. Ja DLSS was beter maar je kreeg bij AMD meer native raster performance voor minder geld.

Bij de huidige gen moet je er vooral op letten dat je zowel bij Blackwell als RDNA4 niet te veel betaald doordat winkels de prijzen opdrijven. FSR4 komt nu heel dicht in de buurt van DLSS4 en verslaat DLSS3. RT prestaties zijn iets lager maar goed genoeg. Prijs is overal lager voor gelijke prestaties/gelijk of meer vram.

9070 XT is +- 650 euro een 5070Ti zit rond de 750 en een 5070 op 550 (al heeft die maar 12GB dus zal sneller niet meer mee kunnen er zijn nu al games die 16GB gebruiken).

--------------------------------------------------

Ik denk dat het probleem van AMD deels een merkperceptie-kwestie is (Nvidia levert al zes generaties op rij het sterkste high-end product), deels te maken heeft met de prestaties in nieuwe technieken zoals path tracing en ray tracing, en deels met de slechte reputatie die FSR nog altijd heeft ten opzichte van DLSS.

(Hoewel FSR 4 echt heel goed is en nauwelijks onderdoet voor DLSS, wis je de negatieve indrukken van FSR 1 t/m 3 niet zomaar binnen een jaar uit.)

Met die merkperceptie en de mindere prestaties zodra consumenten moderne grafische toeters en bellen willen inschakelen, red je het niet als een AMD-kaart van honderden euro’s slechts een paar tientjes goedkoper is dan een Nvidia-kaart.

--------------------------------------------------

Dat was bij DLSS1 en 2 niet anders dat was ook echt waardeloos en onbruikbaar. FSR2/3 Quality is nog bruikbaar net als latere versies van DLSS2 op quality, maar inderdaad liever had je native dat probleem is sinds DLSS3 en FSR4 opgelost.

RT werkt op RDNA4 ook prima. En huidige marktprijs is misschien paar tientjes lager maar dat komt door de markt werking. Want @ launch waren die kaarten veel goedkoper dan de nVidia kaarten in dezelfde prestatie klasse mits je een kaart voor rond de MSRP prijzen kocht en die waren er op zich wel. En nu inmiddels ook weer als je niet de meest luxe modellen koopt.

--------------------------------------------------

Zeker niet als je kijkt naar de prijs van een compleet systeem: wat zijn drie tientjes op een pc van 1500 euro? Mensen kiezen dan toch voor de kaart die beter presteert met de nieuwste features.

--------------------------------------------------

Mee eens als dat verschil klein is en je geen geduld hebt om te zoeken naar onderdelen voor een eerlijke niet door winkels opgeblazen prijs snap ik die keuze zeker als je niets weet over de historie van nVidia of je dat gewoon helemaal niets uit maakt dat ze zaken als Geforce Partner Program er door heen proberen te drukken (ja dat speelt helaas nog steeds alleen in een andere vorm en meer op de achtergrond dan toen voorgesteld)

--------------------------------------------------

(Ik moet er overigens niet aan denken dat de markt voor dedicated GPUs straks volledig beheerst wordt door Nvidia. Ik hoop dat Intel en AMD écht gaan prijsvechten of het Nvidia vlaggenschip eens een keer van de troon stoten)

--------------------------------------------------

Die kans zit er langzaam wel steeds meer in. Maar zolang AMD nog wel wat aan consoles en gaming kan verdienen zal het niet meteen helemaal verdwijnen zeker als ze met dat geld hun AI portfolio verder kunnen ontwikkelen. Daar zit momenteel het grote geld.

[Reactie gewijzigd door Astennu op 4 september 2025 20:28]

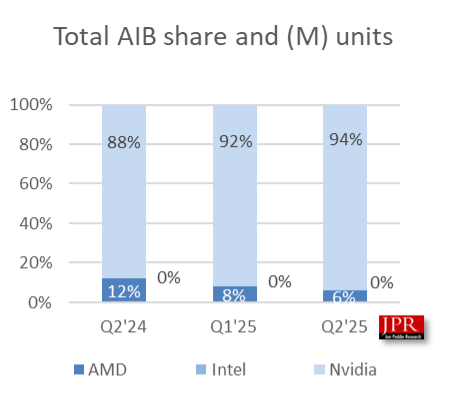

94 procent van alle gpu-leveringen aan boardpartners was in het tweede kwartaal van 2025 afkomstig van Nvidia, aldus Jon Peddie Research. Uit historische data van 3dCenters blijkt dat geen enkele gpu-fabrikant ook zo'n hoog marktaandeel in bezit had. Het marktaandeel van AMD ligt op circa 6 procent, terwijl Intel minder dan een procent in handen heeft.

94 procent van alle gpu-leveringen aan boardpartners was in het tweede kwartaal van 2025 afkomstig van Nvidia, aldus Jon Peddie Research. Uit historische data van 3dCenters blijkt dat geen enkele gpu-fabrikant ook zo'n hoog marktaandeel in bezit had. Het marktaandeel van AMD ligt op circa 6 procent, terwijl Intel minder dan een procent in handen heeft.

:strip_icc():strip_exif()/i/2007742670.jpeg?f=fpa_thumb)

:strip_exif()/i/2007134328.jpeg?f=fpa)

/i/2004611214.png?f=fpa)

/i/2004919460.png?f=fpa)

/i/2004470618.png?f=fpa)