Er zijn verschillende Gigabyte Radeon RX 7600- en GeForce RTX 4060 Ti-videokaarten geregistreerd bij de Eurasian Economic Commission. De registraties bevestigen dat beide kaarten beschikken over 8GB geheugen. Volgens eerdere geruchten komen beide gpu's eind mei uit.

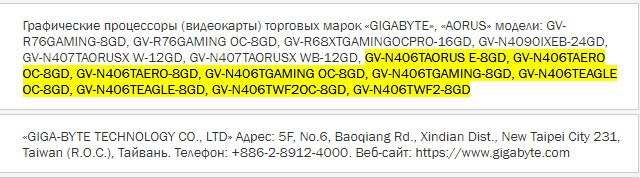

De videokaarten zijn onlangs verschenen bij de EEC, merkte Twitter-gebruiker harukaze5719 op. Gigabyte heeft bij die instantie twee Radeon RX 7600- en negen GeForce RTX 4060 Ti-modellen geregistreerd in de Aorus Extreme-, Aero-, Gaming, Eagle- en WindForce-series van het bedrijf. De verschillende modelnamen noemen allemaal de aanwezigheid van 8GB geheugen.

Er gaan al langer geruchten rond over de komst van beide videokaarten. De GeForce RTX 4060 Ti zou een gpu met 4352 CUDA-cores krijgen en beschikken over 8GB geheugen op een 128bit-geheugenbus. De hoeveelheid geheugen lijkt nu dus bevestigd te zijn door Gigabyte en de EEC. De kaart zou daarnaast een PCIe 4.0 x8-interface krijgen. Nvidia zou de videokaart 'eind mei' willen uitbrengen, maar er is nog geen concrete releasedatum bekend.

De AMD Radeon RX 7600 zou op zijn beurt op 25 mei aangekondigd worden tijdens Computex in Taiwan. Ceo Lisa Su bevestigde deze week dat het dit kwartaal nog met nieuwe RX 7000-videokaarten komt. Concrete specificaties van de RX 7600 zijn nog niet bekend, los van de 8GB geheugen die wordt vermeld in de EEC-registratie.

:strip_exif()/i/2005679924.jpeg?f=fpa)

:strip_exif()/i/2005804374.jpeg?f=fpa)

:strip_exif()/i/2005788828.jpeg?f=fpa)

/i/2004628280.png?f=fpa)

/i/2005106006.png?f=fpa)

/i/2004695548.png?f=fpa)

:strip_exif()/i/2005129898.jpeg?f=fpa)

/i/2004646380.png?f=fpa)