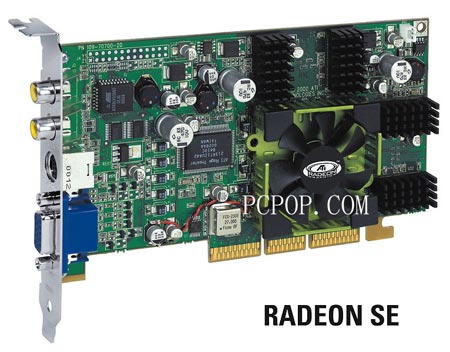

Rage3D heeft van ATi's Brian Hentschel de bevestiging gekregen dat de Radeon II in het vierde kwartaal op de markt wordt gebracht. Volgens vroege speculaties heeft de Radeon II vier rendering pipelines en een core-snelheid van 300MHz, tesamen goed voor een pixel fillrate van 1200Mpix/s. De ontwikkeling van de R200, codenaam van de Radeon II videochip, loopt op schema en deze zomer zullen de eerste samples aan OEMs geleverd worden. In de tussentijd volgt de release van de Radeon SE, een snellere op 250MHz geklokte Radeon naar het idee van de GeForce2 Ultra. De Radeon SE wordt volgens Rage3D in april of mei geïntroduceerd.

|