Mensen van de Chinese site PCPOP hebben een bezoekje gebracht aan ATi's fabriek aldaar en hebben een leuke serie foto's geschoten en gepubliceerd. Het lijkt er verdacht veel op dat ze ook nieuwe ATi Radeon 2 (R200?) videokaarten op de digitale korrel genomen hebben. Zo te zien is men al druk bezig met de productie ervan. Een aantal game developers hebben zich inmiddels zijdelings laten ontvallen, dat ze al R200 samples in hun bezit hebben om een en ander uit te proberen. Reactor Critical heeft de plaatjes ook eens goed bekeken en van wat commentaar voorzien:

|

|

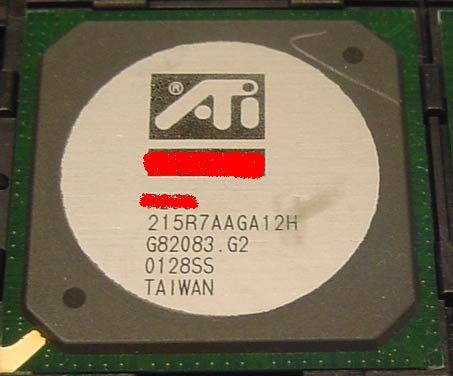

Guys from chinese site PCPOP has been to ATI factory in China and published a lot of interesting photos from there. For example, this picture of card with unknown PCB design based on a chip, which name is crossed with red pen. If we look at the photo carefully, we will probably notice a name of four symbols. And why is it crossed? Maybe it is something secret?And what secret does ATI have at the moment? Surely, R200. If we examine the chip, actually, the first string, which is printed on the top of it, we will be able to notice some pretty interesting mark: "215R7". Keeping in mind that "215R6" means RADEON, we conclude that "215R7" is the mark for R200 or RADEON 2.

[...] Unfortunately, we are not able to determine the revision of this chip, simply because ATI don`t provide such information and basically there are no leaks of such kind of data. By the way, we assume that R200 has finaly gone to mass production - China factory does not produce sample boards, but the cards for China market. So, if there are commercial cards based GPU, we have to wait a couple of weeks till this GPU is announced

Bedankt iefje, voor de tip.