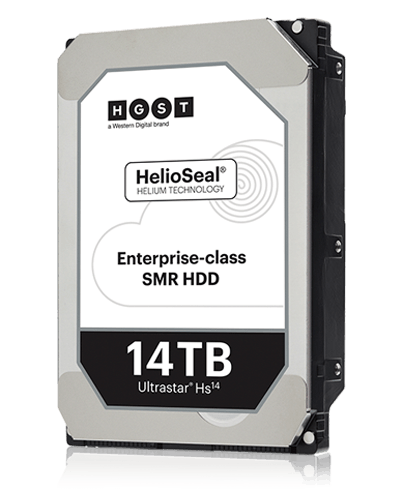

Western Digital heeft de HGST Ultrastar Hs14 aangekondigd, de eerste 3,5"-hdd met een opslagcapaciteit van 14TB. De met helium gevulde harde schijf draait op 7200rpm en is uitgerust met 512MB cache.

Er komen sata- en sas-uitvoeringen van de Ultrastar Hs14. Volgens de fabrikanten is de maximale schrijfsnelheid 233MB/s. De 14TB-hdd is bedoeld voor de zakelijke markt en is volgens maker Western Digital geschikt voor gebruik in servers. De hoge capaciteit is mogelijk dankzij gebruik van smr-techniek, waarbij de magnetische banen elkaar enigszins overlappen.

Er komen sata- en sas-uitvoeringen van de Ultrastar Hs14. Volgens de fabrikanten is de maximale schrijfsnelheid 233MB/s. De 14TB-hdd is bedoeld voor de zakelijke markt en is volgens maker Western Digital geschikt voor gebruik in servers. De hoge capaciteit is mogelijk dankzij gebruik van smr-techniek, waarbij de magnetische banen elkaar enigszins overlappen.

Eind vorig jaar kondigde Western Digital al aan dat de 14TB-hdd op komst was. Toen presenteerde het bedrijf een 12TB-hdd onder de HGST-merknaam, die wat hardware betreft vrijwel gelijk is aan het nieuwe 14TB-model. Meer fabrikanten hebben toegezegd met 14TB-hdd's te komen dit jaar, waaronder Toshiba en Seagate.

WD heeft niet bekendgemaakt wat de prijs is van de Ultrastar Hs14. Het bedrijf zegt dat de hdd op dit moment aan een select aantal oem's wordt verstrekt. Wanneer de 14TB-hdd in de winkels komt te liggen, is nog niet bekend. De Ultrastar He12-hdd met 12TB is te koop voor zo'n vijfhonderd euro.

:strip_icc():strip_exif()/i/2004840588.jpeg?f=fpa_thumb)

/i/1249829841.png?f=fpa)

:strip_exif()/i/1296474747.gif?f=fpa)

/i/2001766573.png?f=fpa)

/i/2000544474.png?f=fpa)

:strip_exif()/i/1282562328.jpeg?f=fpa)

/i/2001655611.png?f=fpa)

:strip_exif()/i/1275386826.jpeg?f=fpa)

:strip_exif()/i/1187938065.gif?f=fpa)

/i/1238484264.png?f=fpa)