nergens in het menselijk brein zit een onveranderbare neurale koppeling die daar door een externe kracht is neergezet en die een complete (gedrags)regel definieert.

Die zijn er meer dan genoeg hoor. Voordat je de associatieve cortices bereikt is vrijwel alles volledig ingebakken. Er is overal ruimte voor plasticiteit, maar bepaalde dingen zoals hoe je sensorische informatie verwerkt wordt, hoe je basale emoties verwerkt worden, cognitieve categoriën zoals ruimte en tijd maakt, hoe je je eerste taal leert, hoe je online beweging en houding corrigeert; allemaal ingebakken.

Ik moet er nu even bijvermelden dat ik een PhD systeem-neurowetenschap doe, dus hierover kan ik redelijk meepraten.

Dit nog afgezien van het feit dat "instinct" geëvolueerd (lettelijk: ontstaan door geleidelijke verandering) is, en niet "ingeprogrammeerd".

Maar wat is het functionele onderscheid? Of een regel ergens in geëvolueerd is of ingeprogrammeerd, maakt toch voor het mogelijke gedrag geen verschil?

Want, om overtredingen te kunnen detecteren van zoiets abstracts als de wetten van Asimov, heb je een systeem nodig van minimaal het soort intelligentie als het systeem dat je probeert te controleren, wat op zijn buurt weer niet gebaseerd kan worden op expliciete regels*

Ja, nu snap ik waarom je het incompleteness theorem erbij haalt! Toch is dat volgens mij niet helemaal juist. Je zegt dat je minstens zoveel intelligentie nodig hebt als het systeem dat je probeert te controlleren, maar hierbij ga je eraan voorbij dat 'intelligentie' zowel uit perceptie bestaat (het verwerken van sensorische informatie) als het formuleren van adaptief gedrag (en feedback hierop, leren van fouten, gebruik van geformuleerde doelen en het adaptief herformuleren van doelen etc).

Nu stel ik de twee volgende mogelijkheden voor.

1) Om verder te gaan waar we gebleven waren, stel ik als eerste een systeem voor dat wel dezelfde mogelijkheden tot sensorische vewerking heeft, maar niet hetzelfde complexe, adaptieve gedrag vertoont. Een systeem dat enkel probeert te categoriseren of een handeling voor de mens goed of slecht is. Dit systeem kan volledig fysiek gescheiden blijven van de hogere faculteiten van het systeem dat onder controle staat. Er zou zelfs gekozen kunnen worden voor een controle systeem dat geen enkele plasticiteit vertoont, dus met ingebakken categoriën (is dit goed, of niet goed voor de mens?). Uiteindelijk wordt het controle systeem natuurlijk complexer naarmate het gecontrolleerde systeem complexer wordt en onze eisen strenger worden, maar formeel zie ik in dit geval problemen.

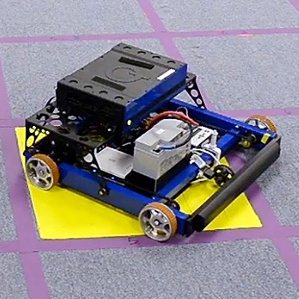

2) Een systeem dat zelfs niet eens hetzelfde sensorum heeft als het gecontrolleerde systeem kan ook al werken, door proxys van gevaar te detecteren. Oftewel een reflexieve 'uit-knop'. Bijvoorbeeld een systeem dat de machine uitschakelt wanneer een mens 'Stop robot!' zegt/roept. Dit kan voor allerlei intelligenties al een effectieve veiligheidsmaatregel zijn, zelfs relatief complexe.

Iets minder abstract dan de wetten van Asimov, aan de andere kant, dekt geen gebied dat breed genoeg is om zinnig te zijn in de context van het doel dat jij schetst.

Dat betwijfel ik dus. Het gaat erom wat in de praktijk gewenst is. Een ideaal systeem dat onder geen enkele omstandigheid de fout in kan gaan is inderdaad onhaalbaar om de redenen die je zelf noemt, maar er zijn zeker benaderingen die veiliger zullen zijn dan waar wij mensen zelf of de huidige technologie toe in staat zijn.

Nu ga ik speculeren, maar er is een gerede kans dat dit al zo'n complex probleem gaat blijken, dat we mens-equivalente AI nodig zullen hebben om zelfs dat op te lossen.

Geloof dat maar gerust. Machines opvoeden is één ding, machines zodanig adaptief maken dat ze bovenmenselijk intelligent zijn, én extreem flexibel gedrag vertonen (wat we willen), én een moreel besef hebben; dat vergt van ons (of andere intelligentie) vaardigheden waar we nu nog eigenlijk niet eens het begin van beheersen, en wat voorlopig (zo niet altijd) bottom-up (door een soort synthetische evolutie) zal moeten plaatsvinden in plaats van top-down door ontwerp.

*Het punt is dat, omdat het controle-systeem concepten als "mens","kwaad","zelfbehoud" etc moet kunnen begrijpen, een volledig mens-equivalent "common sense reasoning" systeem nodig is, wat weer niet logica-gebaseerd kan.

Ik beweer dus, dat het controlesysteem bij lange na niet zo complex hoeft te zijn als het syteem wat het moet beveiligen; omdat de te vermijden situaties (waarbij mensen bedreigd worden of gevaarlijke situaties ontstaan) een erg specifieke en herkenbare subset van alle mogelijke ervaringen van de machine is, die door een relatief eenvoudig systeem te herkennen moeten zijn, wat vervolgens via een directe weg de machine kan uitschakelen, zonder hierbij contact te maken met het gecontroleerde systeem.

Het enige probleem wat ik hierbij voorzie, is dat machines met bovenmenselijke intelligentie volgens mij een manier moeten kunnen bedenken om deze beperkingen te omzeilen.

:strip_exif()/i/1190903522.jpg?f=fpa)

/i/1284371238.png?f=fpa)

/i/1102067282.png?f=fpa)

:strip_exif()/i/1396886565.jpeg?f=fpa)

/i/1386829171.png?f=fpa)

/i/1347363581.png?f=fpa)

:strip_exif()/i/1286274802.jpeg?f=fpa)

/i/1225133057.png?f=fpa)

:strip_exif()/i/1138546628.jpg?f=fpa)

/i/1233670851.png?f=fpa)

:strip_exif()/i/1068828305.jpg?f=fpa)

/i/1253887911.png?f=fpa)