De specificaties en het pcb-ontwerp van Nvidia's nieuwe budget-videokaart GT218 zijn bekend geworden. Nvidia's eerste 40nm-gpu zal in minstens vier varianten verschijnen. De GT218-gpu ondersteunt onder meer dual link-dvi en displayport.

Volgens VR-Zone zal de GT218-gpu-kern op 550MHz worden geklokt, terwijl de shaderklok op 1375MHz draait. De kaart zal worden voorzien van 512MB ddr3-geheugen dat op een snelheid van 800MHz loopt en via een 64bit-bus met de gpu verbonden is. Het is niet bekend met hoeveel shaderprocessors Nvidia de GT218 heeft uitgerust. De GT218-gpu is de opvolger van de G98-gpu; een videokaart op basis van de GT218-gpu zou volgens Fudzilla 22W verbruiken.

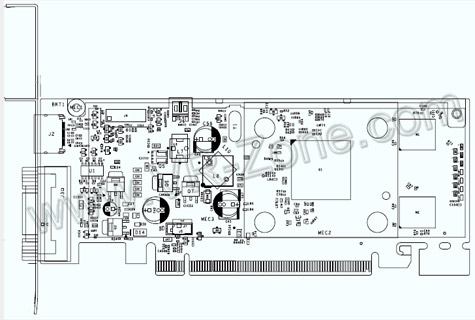

Het pcb-ontwerp waarop VR-Zone de hand heeft weten te leggen, betreft versie P692 met als codenaam D10M1-30, en toont een tamelijk kleine printplaat waarop de GT218-package te zien is met zijdes van 23mm. Het GT218-referentieontwerp biedt plaats aan twee externe connectors op de slotplaat, maar de GT218-gpu zelf biedt ondersteuning voor onder meer dual link-dvi, displayport en vga. De eerste proefexemplaren van de GT218 zullen waarschijnlijk op de CeBIT in maart te bewonderen zijn, met een verwachte marktintroductie in april.

/i/1246368532.png?f=fpa)

/i/1208164214.png?f=fpa)

/i/1236093102.png?f=fpa)

/i/1214223517.png?f=fpa)

/i/1234865315.png?f=fpa)

/i/1215689845.png?f=fpa)