Er zijn enkele specificaties van Nvidia's eerste 40nm-gpu's opgedoken. De G216 en de G218, Nvidia's eerste DirectX 10.1-gpu's, zullen toegepast worden op respectievelijk de G210 en de GT220. Deze budgetkaarten komen in oktober uit.

Voordat Nvidia zijn op 40nm gebakken DirectX 11-gpu's uitbrengt, komt de gpu-gigant eerst met een aantal 40nm-gpu's die nog op de bestaande architectuur zijn gebaseerd, al ondersteunen deze gpu's wel DirectX 10.1 in plaats van DirectX 10. De eerste videokaarten met een dergelijke 40nm-gpu zijn twee budgetkaarten, de G210 en de GT220, die respectievelijk zijn voorzien van de G218- en de G216-gpu. De G218 heeft 24 shaderprocessors en een 64bit-geheugenbus, die overweg kan met zowel ddr2- als gddr3-geheugen. VR-zone wist de hand te leggen op de G210 en las de kloksnelheden van de gpu, de shaders en het geheugen uit met GPU-z, dat respectievelijk 603MHz, 1425MHz en 790MHz liet zien. Een G210-chip zou 30 tot 35 dollar moeten gaan kosten.

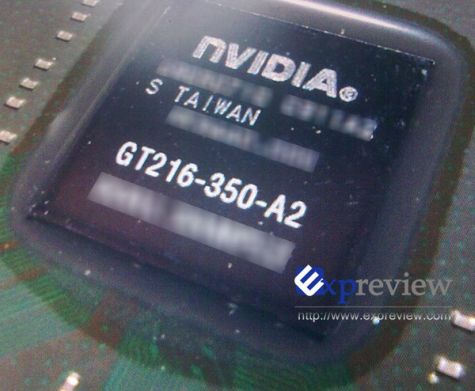

De G216 is twee keer zo snel, met 48 shaderprocessors en een 128bit-geheugenbus, die maximaal 1GB aan ddr2-, ddr3- of gddr3-geheugen aan kan spreken. De gpu zal gebruikt worden op de GT220, en de GT220 die VR-zone wist te bemachtigen had kloksnelheden van 625MHz, 1373MHz en 790MHz voor respectievelijk de gpu, de shaders en het geheugen. De website Expreview wist de gpu op de gevoelige plaat vast te leggen, maar behalve de gpu valt er weinig te zien. De GT220 moet pakweg 60 dollar gaan kosten. Beide DirectX 10.1-gpu's zullen in oktober beschikbaar komen. Wanneer Nvidia op de proppen komt met de 40nm-gpu's die van DirectX 11-ondersteuning zijn voorzien, is nog onbekend.

/i/1255349829.png?f=fpa)

/i/1248347522.png?f=fpa)

:strip_exif()/i/1123776957.jpg?f=fpa)

/i/1206089508.png?f=fpa)

/i/1245096154.png?f=fpa)

/i/1241163398.png?f=fpa)

/i/1208164214.png?f=fpa)