Een nieuw type geheugen op basis van nanodraden is in staat computerdata honderdduizend jaar te bewaren en gegevens duizend keer sneller tevoorschijn te toveren dan flashgeheugen.

Bovendien kan de nieuwe technologie tot aanzienlijk kleinere geheugenmodules leiden en die ook nog veel minder energie verbruiken, aldus de universiteit van Pennsylvania. Een team van wetenschappers maakte voor hun vinding gebruik van nanodraden van germanium antimoontellurium, een materiaal dat van fase verandert en tussen amorfe en kristallijne structuur wisselt.

Bovendien kan de nieuwe technologie tot aanzienlijk kleinere geheugenmodules leiden en die ook nog veel minder energie verbruiken, aldus de universiteit van Pennsylvania. Een team van wetenschappers maakte voor hun vinding gebruik van nanodraden van germanium antimoontellurium, een materiaal dat van fase verandert en tussen amorfe en kristallijne structuur wisselt.

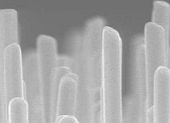

Bij de fabricage van het geheugen vertrouwden de wetenschappers niet op lithografie, maar op zelf-assemblage, dat ervoor zorgde dat er spontaan draadjes met een diameter van 30 a 50 nanometer en een lengte van 10 micrometer ontstonden. Vervolgens werd het resultaat op een siliciumsubstraat aangebracht.

Bij het testen van de nieuwe geheugentechnologie kwam een extreem laag energieverbruik, 0,7mW per bit, naar voren dat benodigd was voor het encoderen van data. Ook werd duidelijk dat lezen, schrijven en terughalen van gegevens vijftig nanoseconden kostte, grofweg duizend keer zo snel als flashgeheugen. Verder zou data zelfs na 100.000 jaar gebruik niet verloren gaan.

Volgens Ritesh Agarwal van het onderzoeksteam kan de technologie voor een revolutie zorgen op geheugengebied: 'Stel je voor dat je honderden films in hoge resolutie kunt opslaan op een kleine schijf en dat je ze kunt afspelen zonder dat je tijd verliest aan bufferen. Of stel je voor dat je laptop in een paar seconden opstart.' De wetenschappers verwachten dat over acht tot tien jaar de techniek in de praktijk kan worden toegepast.

:strip_exif()/i/1196085296.gif?f=fpa)