Het wordt mogelijk om de toon van ChatGPT verder aan te passen. OpenAI heeft daarvoor een update uitgerold. Gebruikers kunnen zo meerdere 'karaktertrekken' van de chatbot finetunen, zoals hoe warm of enthousiast deze is.

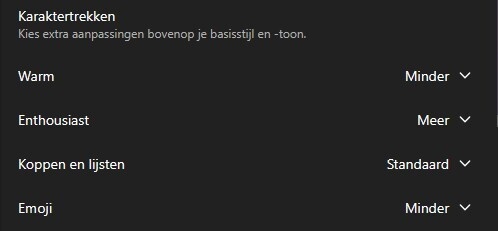

OpenAI stelde de update op vrijdagavond beschikbaar voor ChatGPT-gebruikers, meldt het bedrijf op sociale media. De nieuwe opties zijn te vinden in de instellingen van ChatGPT, onder 'personalisatie'. Gebruikers krijgen vier verschillende karaktertrekken om aan te passen, ieder met drie niveaus: 'minder', 'standaard' of 'meer'.

Met 'warm' kunnen gebruikers instellen of de chatbot vriendelijk of juist zakelijk is, met 'enthousiast' kan ChatGPT energieker of juist kalmer communiceren, en met 'koppen en lijsten' zal ChatGPT meer of juist minder tussenkopjes en lijstjes met bulletpoints gebruiken. Tot slot is er ook een optie die het emojigebruik van de AI-dienst regelt.

Naast die opties heeft de chatbot al mogelijkheden om de 'algemene' persoonlijkheid van de chatbot in te stellen. Dat is mogelijk sinds de release van GPT-5.1. Ook die optie is te vinden onder de personalisatieopties en biedt keuzes als 'professioneel', 'oprecht', 'nerdy' en 'cynisch'.

/i/2007970612.webp?f=fpa)

/i/1348829391.png?f=fpa)

:strip_exif()/i/2007853496.jpeg?f=fpa)

/i/2006829312.png?f=fpa)

:strip_exif()/i/2004698112.jpeg?f=fpa)

:strip_exif()/i/2007654988.jpeg?f=fpa)

:strip_exif()/i/2005545080.jpeg?f=fpa)

/i/2007919110.webp?f=fpa)