Google Chrome gaat in de toekomst geen http-elementen meer laden op verder versleutelde pagina's. Op websites met https-verbindingen die ook niet-versleutelde elementen bevatten worden die laatste niet meer zomaar ingeladen.

Dergelijke 'gemixte content' wordt in de toekomst geblokkeerd in Chrome, schrijft Google in een blogpost. De browser zorgt er dan voor dat https-websites alleen nog maar https-content kunnen laden. Google wil daarmee de privacy en veiligheid van gebruikers verbeteren. Volgens het bedrijf surfen internetgebruikers inmiddels meer dan 90 procent van hun tijd over een versleutelde verbinding.

Chrome blokkeert dergelijke gemixte content op dit moment al in bepaalde gevallen. Dat gebeurt als het gaat om onversleutelde scripts of iframes. Multimediale content zoals afbeeldingen, audio of video worden echter gewoon nog afgespeeld, ook als zij niet met https versleuteld zijn. Daardoor kunnen aanvallers in principe zulke content gebruiken om malware of trackingcookies naar bezoekers te sturen. Bovendien, zegt Google, zorgt dergelijke gemixte content voor verwarrende signalen voor gebruikers. Die zien in hun url-balk weliswaar dat een site met ssl is versleuteld, maar dat er 'delen onveilig zijn.'

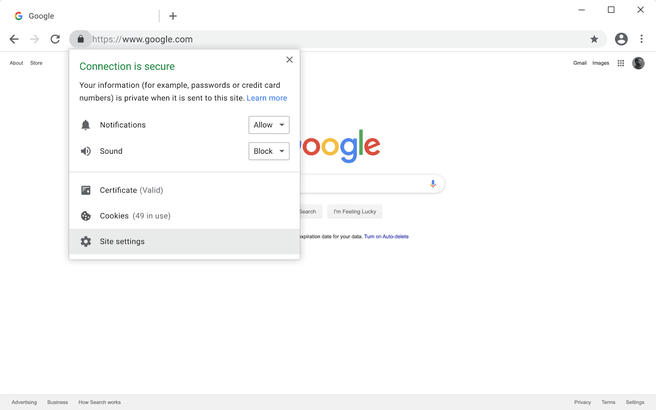

De verandering vindt niet van de ene op de andere dag plaats. In Chrome 79 komt er een nieuwe instelling waarmee gebruikers gemixte content handmatig kunnen aan- of uitzetten. Die zit in hetzelfde menu als waar gebruikers meer informatie kunnen vinden over de beveiliging van een site. In Chrome 80 worden audio- en video-elementen automatisch via https verstuurd, of worden ze geblokkeerd als dat niet lukt. Bij het gebruik van onversleutelde afbeeldingen krijgen gebruikers de melding te zien dat de hele website onveilig is. In Chrome 81, dat uitkomt in februari volgend jaar, worden alle onveilige elementen automatisch geblokkeerd.

/i/2002191883.png?f=fpa)

/i/1361875630.png?f=fpa)

:strip_exif()/i/2002832162.jpeg?f=fpa)

/i/1260868188.png?f=fpa)

/i/2002832222.png?f=fpa)

/i/1349257392.png?f=fpa)

/i/1300877312.png?f=fpa)