Gebruikers melden dat ze de pas uitgebrachte RTX Voice-app werkend hebben gekregen op non-RTX-videokaarten van Nvidia. De applicatie zou gebruikmaken van tensorcores en daardoor niet op dergelijke gpu's werken.

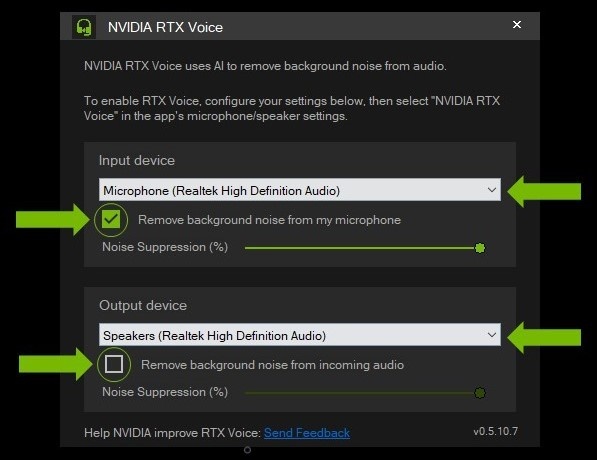

RTX Voice is een applicatie die met kunstmatige intelligentie in real time achtergrondgeluid kan filteren uit microfoons en speakers. Hiervoor zou de applicatie gebruikmaken van speciale tensorcores, die onder andere worden gebruikt in recente RTX-videokaarten van Nvidia. Het bedrijf bracht de applicatie eerder deze maand uit als bètaversie, omdat veel mensen momenteel vanuit huis werken. De software zou echter alleen bedoeld zijn voor recente RTX-gpu's, zo schrijft de fabrikant in een blogpost.

Forumbezoekers van Guru3D kregen de applicatie toch volledig werkend op andere Nvidia-gpu's. Ontdekker David Lake deed dit door een temp-bestand aan te passen tijdens het installatieproces. Hiermee kreeg de forumbezoeker de applicatie werkend op zijn Titan V, die ook over tensorcores beschikt. Al snel meldden gebruikers echter dat deze methode ook werkt op oudere gpu's, zonder dergelijke cores. De software zou hierdoor bijvoorbeeld draaien op Pascal-gpu's. Ook videokaarten in de GTX 1600-serie zouden werken. Maxwell-gpu's bieden volgens David Lake 'gemengde resultaten'. Er gingen eerder geruchten rond dat een GTX 580 uit 2010 zou werken, maar dit is later ontkracht.

Het is onduidelijk hoe het precies werkt, maar TechPowerUp schrijft dat de software misschien gebruikmaakt van een op cuda gebaseerde codepath. Hiervoor zijn tensorcores niet nodig. Instructies voor het installeren van de software op non-RTX-gpu's staan op Guru3D.

De RTX Voice-applicatie

:strip_exif()/i/2001087247.png?f=thumbmedium)

:strip_exif()/i/2004618302.jpeg?f=fpa)

/i/2004442146.png?f=fpa)

/i/2000820476.png?f=fpa)

:strip_exif()/i/2002170155.jpeg?f=fpa)

:strip_exif()/i/2003521894.jpeg?f=fpa)

/i/2001507511.png?f=fpa)

:strip_exif()/i/2002463806.jpeg?f=fpa)