Onderzoekers van Samsung hebben de levensduur verbeterd van resistief random access memory, een relatief nieuw type niet-vluchtig geheugen. Het aantal lees- en schrijfcycli zou zijn uitgebreid tot een biljoen en het reram zou ook zuiniger zijn.

De werking van resistief ram, of r(e)ram, is enigszins vergelijkbaar met dat van phase change-geheugen. Cellen in resistief geheugen kunnen onder invloed van elektriciteit in een isolerende of geleidende staat gebracht worden. In een isolerend diëlektricum kan door het aanbrengen van een hoge spanning een geleidend kanaal worden gevormd. Dat geleidende kanaal kan door het aanbrengen van een tweede spanning worden afgebroken, waardoor het materiaal weer geen spanning geleidt. Dit verschijnsel kan voor data-opslag worden ingezet.

Reram zou op termijn als opvolger van nand-geheugen kunnen dienstdoen, maar net als bij dat type geheugen is de levensduur van reram beperkt. Het aantal cycli waaraan het diëlektricum kan worden blootgesteld, is immers niet oneindig. Onderzoekers van het Samsung Advanced Institute of Technology hebben, in samenwerking met de universiteit van Sejong, een materiaal ontwikkeld dat een biljoen lees- en schrijfcycli zou kunnen doorstaan. Het diëlektricum bestaat uit een bilaag van twee soorten tantaaloxide dat tussen twee platina elektrodes is geklemd.

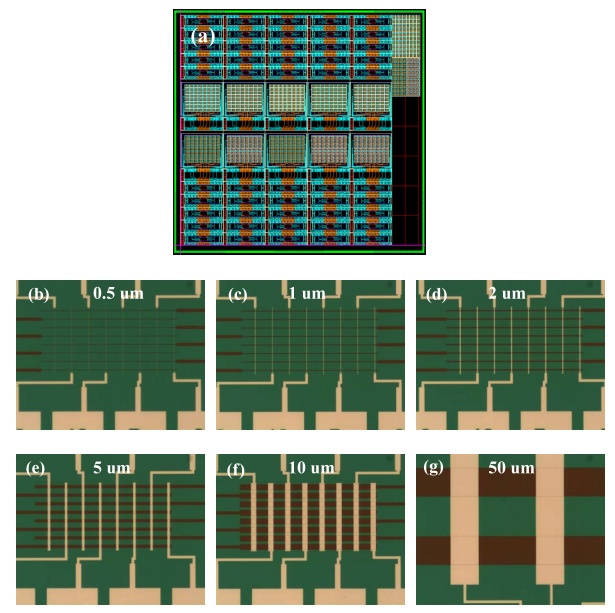

De onderzoekers hebben de afmetingen van de geheugencellen teruggebracht van 50 bij 50 micrometer naar 30 bij 30 nanometer. Bovendien kan het geheugen op elkaar worden gestapeld om de dichtheid verder te vergroten. Test-arrays van tien bij tien cellen bleken in staat om data gedurende tien jaar, bij een temperatuur van 85 graden, vast te houden. De schakeltijd van de cellen bedroeg 10ns en het geheugen zou zuiniger zijn dan eerder geproduceerd reram.

/i/1234873450.png?f=fpa)

/i/1371124186.png?f=fpa)

:strip_exif()/i/1305194036.jpeg?f=fpa)

/i/1217925693.png?f=fpa)

:strip_exif()/i/1032120392.gif?f=fpa)

/i/1236764309.png?f=fpa)

/i/1246105319.png?f=fpa)

:strip_exif()/i/1286274802.jpeg?f=fpa)

/i/1284994179.png?f=fpa)

/i/1272440032.png?f=fpa)

/i/1242207182.png?f=fpa)