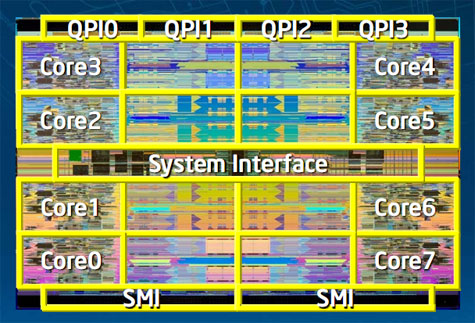

Intel heeft een vooruitblik gepubliceerd over zijn nieuwe Nehalem-EX-processor. De octacore-serverchips moeten in moederborden met maximaal acht sockets geprikt worden en beschikken over hyperthreading-technologie.

Een volledig met Nehalem-EX-cpu's bezet moederbord met acht sockets kan over maar liefst 128 threads beschikken. Met behulp van knooppunt-controllers van derden zouden meerdere 128threads-systemen aan elkaar geknoopt kunnen worden. De maximaal acht cores van de nieuwe Xeon-processors, die Intel verwacht later dit jaar uit te brengen, delen gezamenlijk 24MB cache. De hyperthreading-cpu's zullen elk 16 geheugenslots kunnen aanspreken en beschikken ieder over vier QPI-interconnects. De EX-chips zullen volgens een 45nm-procedé worden geproduceerd, waarbij Intels high-k metal gate- techniek voor efficiënte processors moet zorgen. De Nehalem-EX met acht cores zal opgebouwd worden uit 2,3 miljard transistors.

De octacore-Xeons moeten de huidige Xeon 7400-lijn opvolgen. Deze hexacores worden uitgerust met 16MB cache, wat bij de Nehalem-EX-serie wordt vergroot tot 24MB. De vergrote cache en de extra threads moeten onder meer voor soepeler virtualisatie zorgen, terwijl de Nehalem-processors over negen keer meer geheugenbandbreedte dan de Xeon 7400-serie zou beschikken. Bovendien zullen servers die met de Nehalem-Xeons worden uitgerust met ras-features als mca-recovery, wat moet bijdragen aan hun kosteneffectieve inzetbaarheid.

/i/1238441284.png?f=fpa)

/i/1242207182.png?f=fpa)

/i/1221502237.png?f=fpa)

/i/1239185206.png?f=fpa)

:strip_exif()/i/1238507804.gif?f=fpa)

:strip_exif()/i/1223915640.gif?f=fpa)

/i/1236253208.png?f=fpa)

/i/1198494081.png?f=fpa)

/i/1212686472.png?f=fpa)