AnandTech werpt een blik op de hardwarematige H.264-acceleratie van de GeForce 8600. Nvidia - dat normaal altijd achterloopt met dit soort features - is ATi in dit geval te snel af, maar hoe goed werkt het?

H.264 is de zwaarste van de drie codecs die worden ondersteund door blu-ray en hd-dvd. Het levert goede kwaliteit, maar eist ook erg veel van de processor. Zelfs een relatief snelle dualcore kan nog een flinke kluif hebben aan het verwerken van een hd-stroom. Oudere videochips kunnen hier wel een beetje bij helpen, maar laten het zware werk nog steeds aan de cpu over. De pas geleden uitgebrachte GeForce 8500/8600-kaarten zijn de eerste met volledig hardwarematige H.264-decodering, inclusief het decrypten van aacs-beveiliging. Gek genoeg heeft de duurdere GeForce 8800 deze functie niet en het is ook niet duidelijk of hij hem ooit nog zal krijgen.

Om te beginnen met de test worstelt AnandTech met softwareproblemen. PowerDVD en WinDVD bieden dan wel ondersteuning voor blu-ray en hd-dvd, maar hebben nog (regelmatig) last van crashes. Helemaal onder de 64-bit versie van Vista en in combinatie met de acceleratie van ATi zijn de problemen sterk aanwezig. Met een beetje doorzettingsvermogen weet men uiteindelijk toch benchmarks voor drie hd-films te verzamelen: Yozakura, The Interpreter en Serenity.

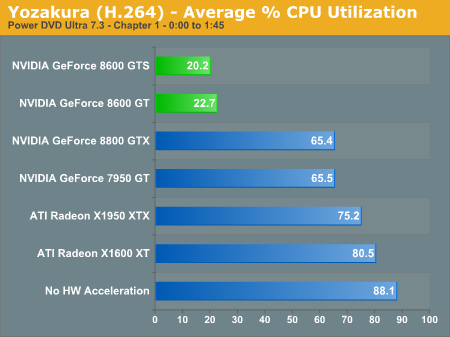

Tijdens het weergeven van de eerste 105 seconden van de eerste film zónder gpu-versnelling heeft PowerDVD gemiddeld 88% van de rekenkracht van een Core 2 Duo E6320 nodig. Met hardwarematige decodering zakt het verbruik naar rond de 21%. De veel duurdere 8800 GTX laat de processor voor 65,4% belast, omdat hij op dit gebied minder features heeft dan zijn kleine broertjes. De huidige topkaart van ATi komt op 75,2% uit. WinDVD is over het geheel genomen iets efficiënter dan PowerDVD, maar mist ondersteuning voor de functies van ATi en is daarom minder interessant om te vergelijken. De tweede film laat ongeveer hetzelfde beeld zien als de eerste. Voor de derde film heeft de feature minder effect, omdat deze met een ander codec (VC-1) is gemaakt. Deze codec is sowieso minder zwaar dan H.264 (puur softwarematig hoeft er maar 35,9% voor afgetikt worden) en de gpu kan daar nog een procent of tien vanaf scheren.

Naast prestaties komt ook het stroomverbruik nog even aan bod. Gemiddeld verbruikt het systeem 135,1 watt tijdens het decoderen met de cpu en 124,8 watt met de gpu. Een marginaal verschil, maar het is in ieder geval niet zo dat de besparing die de processor maakt teniet wordt gedaan door videokaart. De conclusie luidt dat er behalve de nog steeds brakkige ondersteuning voor blu-ray/hd-dvd in pc-software geen nadelen zijn aan het gebruik van hardwarematige decodering. Vooral de goedkope GeForce 8500 is een erg interessante optie voor bouwers van htpc-

:fill(white):strip_exif()/i/2000783371.jpeg?f=thumbmedium)

:strip_exif()/i/1188993549.jpg?f=thumbmedium)

:strip_exif()/i/1164566211.gif?f=fpa)

:fill(white):strip_exif()/i/2000783398.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783427.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783379.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783308.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1307715066.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000784532.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783632.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783548.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783503.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783447.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783461.jpeg?f=thumbmedium)

:strip_exif()/i/1259934668.png?f=thumbmedium)

:fill(white):strip_exif()/i/2000783378.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1218802326.jpg?f=thumbmedium)

:fill(white):strip_exif()/i/1218801927.jpg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783346.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783426.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783431.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1223539873.jpg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783697.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/1223538962.jpg?f=thumbmedium)

:fill(white):strip_exif()/i/2000784765.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783389.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783499.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783485.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783315.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783582.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783530.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783500.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2000783386.jpeg?f=thumbmedium)

:strip_exif()/i/1176833012.jpg?f=fpa)