Het energieverbruik van hardware - met processors in het bijzonder - is een heikel punt, zo bleek ook twee dagen geleden weer. Met de Brisbane-core heeft AMD zijn Athlon 64 X2's zuiniger gemaakt en uiteraard kon Intel niet achterblijven.

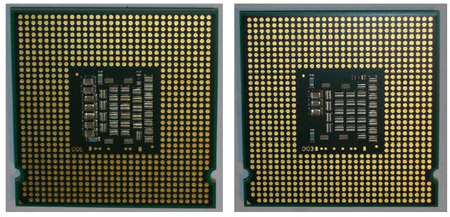

Intel pakt het deze keer niet al te groot aan; alleen de Core 2 Duo E6300 en E6400 met ieder 2MB L2-cache krijgen een nieuwe revisie, waarin de processors iets zuiniger zullen omspringen met de energie wanneer ze niks staan te doen. In idle-toestand heeft Intel het stroomverbruik van de Core 2 Duo's weten terug te dringen van 22 naar 12 watt, AMD's Brisbane-cpu's hebben idle aan 7,5 watt genoeg. De tdp-waarde van de Core 2 Duo's is met 65 watt ongewijzigd gebleven, waardoor deze gelijk blijft aan die van de Brisbanes. Het vergelijken van tdp-waardes heeft echter vrij weinig nut, aangezien Intel een gemiddelde tdp handhaaft en AMD spreekt over maximum tdp. In de toekomst zullen er ook revisies verschijnen voor zowel de Xeon 3040- en 3050-server-cpu's als de Core 2 Duo E4x00-serie en uiteindelijk ook voor de Core 2 Duo E6600 en E6700.

Intel pakt het deze keer niet al te groot aan; alleen de Core 2 Duo E6300 en E6400 met ieder 2MB L2-cache krijgen een nieuwe revisie, waarin de processors iets zuiniger zullen omspringen met de energie wanneer ze niks staan te doen. In idle-toestand heeft Intel het stroomverbruik van de Core 2 Duo's weten terug te dringen van 22 naar 12 watt, AMD's Brisbane-cpu's hebben idle aan 7,5 watt genoeg. De tdp-waarde van de Core 2 Duo's is met 65 watt ongewijzigd gebleven, waardoor deze gelijk blijft aan die van de Brisbanes. Het vergelijken van tdp-waardes heeft echter vrij weinig nut, aangezien Intel een gemiddelde tdp handhaaft en AMD spreekt over maximum tdp. In de toekomst zullen er ook revisies verschijnen voor zowel de Xeon 3040- en 3050-server-cpu's als de Core 2 Duo E4x00-serie en uiteindelijk ook voor de Core 2 Duo E6600 en E6700.

/i/1157717307.png?f=fpa)

:strip_exif()/i/1154527731.gif?f=fpa)

:strip_exif()/i/1149584728.jpg?f=fpa)

:strip_exif()/i/1166195218.jpg?f=fpa)