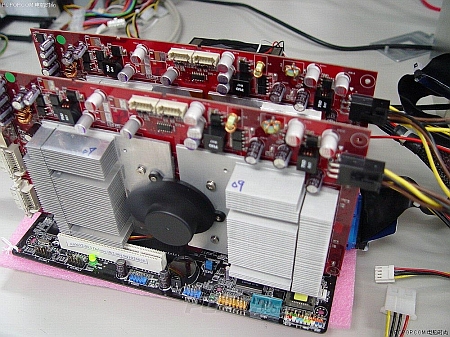

Al sinds de introductie van de SLI-technologie spreekt het idee van vier videokaarten die samenwerken tot de verbeelding en nu is ook Asus daarmee, niet zonder succes, aan het experimenteren gegaan. Enkele Chinese journalisten wisten de hand op wat foto's van testconfiguraties met twee dual GeForce 7800 GT's, goed voor een totaal van vier gpu's, te leggen. Voor het testen werd blijkbaar gebruikgemaakt van twee Asus EN7800 GT Dual-videokaarten die beide voorzien zijn van twee GeForce 7800 GT-cores en 512MB geheugen. Deze twee kaarten werden op een Asus A8N32-SLI Deluxe Revision 2.0 geprikt en waren verbazingwekkend genoeg niet verbonden met behulp van een MIO-connector die zo typisch is voor nVidia's SLI-technologie. Uit een Windows-screenshot blijkt dat de SLI-constructie herkend wordt als vier individuele videokaarten. Jammergenoeg wisten de Chinezen niet te vertellen welke score het systeem haalde in 3DMark05, maar gaven ze wel enkele screenshots en foto's van de opstelling vrij. De gebruikte driverversie werd niet vrijgegeven, maar het lijkt er op dat er nog wat werk aan de winkel is om de technologie op punt te stellen, gezien de storingen in het beeld.