Nog geen twee maanden nadat nVidia de GeForce 7800 GTX op de markt bracht heeft het bedrijf vandaag de lichte variant van deze kaart te koop gezet: de GeForce 7800 GT. 'Licht' is eigenlijk wel een understatement: de kaart beschikt over een op minstens 400MHz geklokte G70-core met 20 pixelpipelines en 256MB GDDR3-geheugen dat op 1000MHz data rondpompt. De kaart is een flink stuk goedkoper dan de grote GTX-broer: met 450 euro zal de GT rond de honderdvijftig euro goedkoper uitpakken. Dat prijsverschil suggereert een groter verschil dan er in werkelijkheid is: de GeForce 7800 GT is in feite wel degelijk een van de zware jongens.

De kaart is van alle hard- en softwarematige gemakken voorzien: twee DVI-aansluitingen, VIVO, HDTV, Shader Model 3.0, SLI, en alles waar ook de GTX over kan beschikken: Natuurlijk zijn een aantal specificaties iets minder dan die van de grote broer: de GTX heeft vier pipelines extra, de core loopt 30MHz harder, het geheugen loopt zelfs 200MHz harder; en de GT levert maar 8 gigatexels tegen de 10,3 gigatexels van de GTX. Maar het beste nieuws is toch wel dat de kaart vrij soepel overklokt - zelfs zo soepel dat een aantal modellen al in de fabriek op overklokkoers worden gezet. HardOCP beschikte over een BFGTech die op 425/1050MHz was geklokt; en TechReport bechikte men over een XFX-model dat op 450MHz liep.

De kaart is van alle hard- en softwarematige gemakken voorzien: twee DVI-aansluitingen, VIVO, HDTV, Shader Model 3.0, SLI, en alles waar ook de GTX over kan beschikken: Natuurlijk zijn een aantal specificaties iets minder dan die van de grote broer: de GTX heeft vier pipelines extra, de core loopt 30MHz harder, het geheugen loopt zelfs 200MHz harder; en de GT levert maar 8 gigatexels tegen de 10,3 gigatexels van de GTX. Maar het beste nieuws is toch wel dat de kaart vrij soepel overklokt - zelfs zo soepel dat een aantal modellen al in de fabriek op overklokkoers worden gezet. HardOCP beschikte over een BFGTech die op 425/1050MHz was geklokt; en TechReport bechikte men over een XFX-model dat op 450MHz liep.

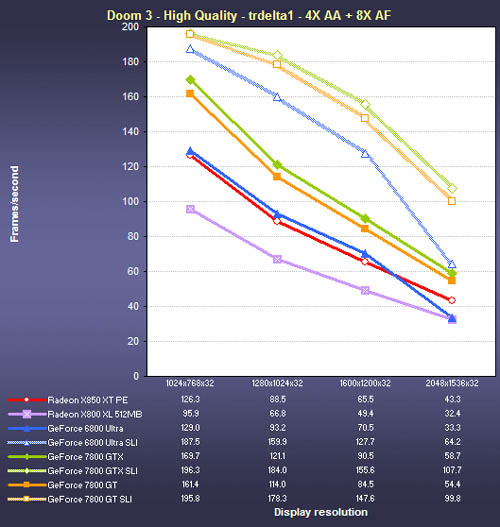

Veel concurrentie heeft de 7800 GT niet. Uiteraard, van twee kaarten in SLI-opstelling wordt verloren en ook de GTX moet voorgelaten worden, maar dan? De 6800 kwam af en toe een beetje in de buurt, en de ATi 850 XT PE kon de nieuwe GeForce-loot met enige regelmaat bijhouden, maar ervoorbij was meestal toch teveel gevraagd. Diverse sites controleerden hoever de nieuwe kaart overgeklokt kon worden, en hoewel 450/1050 er misschien niet direct spectaculair uitziet, waren er genoeg sites die een dergelijke overclock realiseerden om te verwachten dat er nog wel wat marge in de core zit. Nu al moeten de GTX'en het in heel wat benchmarks afleggen tegen een opgevoerde GT.

Veel concurrentie heeft de 7800 GT niet. Uiteraard, van twee kaarten in SLI-opstelling wordt verloren en ook de GTX moet voorgelaten worden, maar dan? De 6800 kwam af en toe een beetje in de buurt, en de ATi 850 XT PE kon de nieuwe GeForce-loot met enige regelmaat bijhouden, maar ervoorbij was meestal toch teveel gevraagd. Diverse sites controleerden hoever de nieuwe kaart overgeklokt kon worden, en hoewel 450/1050 er misschien niet direct spectaculair uitziet, waren er genoeg sites die een dergelijke overclock realiseerden om te verwachten dat er nog wel wat marge in de core zit. Nu al moeten de GTX'en het in heel wat benchmarks afleggen tegen een opgevoerde GT.

Diverse sites waarschuwen de lezer dat wie in de afgelopen maanden een nieuwe kaart heeft gekocht, zich vandaag bekocht voelt: nVidia heeft met de 7800 GT een relatief voordelige en ijzersterke troef in handen. Als men zich dan realiseert dat naast de krachtpatserij van de 7800's de 6800-modellen ook nog een lagere prijs krijgen, is het niet gek om te veronderstellen dat de fabrikant de komende tijd aardig wat marktaandeel op concurrent ATi kan veroveren. Het is voor dat bedrijf dan ook te hopen dat CrossFire of de langverwachte X900 binnenkort op de markt komt - nVidia zou eens lui van deze voorsprong kunnen worden.

Een greep uit de grote hoeveelheid reviews:

:strip_exif()/i/1144748421.jpg?f=thumbmedium)

:strip_exif()/i/1123520030.gif?f=fpa)