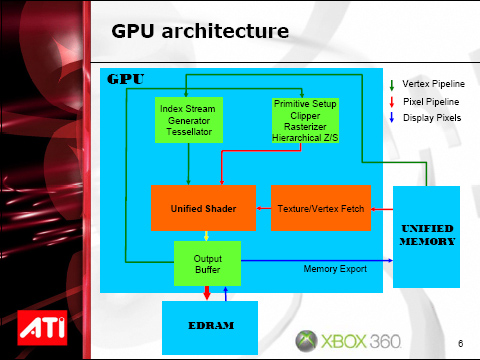

ATi heeft nieuwe documentatie vrijgegeven over de Xenos, de videoprocessor die ontwikkeld werd voor de Xbox 360. De chip is geklokt op 500 MHz en beschikt over 48 shader pipelines, waarmee dit meteen de eerste commerciële grafische chip is die een 'unified shader architecture' heeft. Dit betekent dat er niet langer gewerkt wordt met een afzonderlijke vertex shader en pixel shader, maar dat één onderdeel beide shaders verzorgt.

De twee cores zijn samen goed voor 232 miljoen transistors op de 'parent die' en nog eens 100 miljoen op de dochter-die die onder andere als frame buffer dient. Deze kleinere die wordt overigens geproduceerd door NEC Electronics en wordt op 90nm gebakken. Voor de communicatie met deze dochter-die beschikt de gpu over een 32GBps-kanaal, terwijl de communicatie met de processor via twee lijnen die elk goed zijn voor 10,8GB per seconde loopt. Om het GDDR3-geheugen aan te spreken beschikt de gpu over een verbinding die 128 bits breed is en op 700MHz geklokt is, zodat een doorvoer van 22,4GBps mogelijk is.