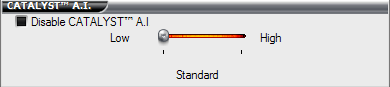

Na vele maanden discussie over waar de grens tussen optimalisaties en cheats ligt komt ATi in zijn nieuwste drivers (de aanstaande versie 4.10) met Catalyst A.I., een instelling waarmee applicatie-specifieke en/of min of meer omstreden optimalisaties aan- of uitgezet kunnen worden. Hiermee kan bijvoorbeeld het originele algortime voor trilinear filteren weer gekozen worden, of toestemming gegeven worden om shaders en textures in spellen als Doom 3, Unreal Tournament 2004 en Half-Life 2 te vervangen. Elite Bastards heeft een preview van de nieuwe drivers online gezet, waarin gekeken wordt naar de beeldkwaliteit en prestaties van de optimalisaties in verschillende spellen. Het blijkt dat de visuele verschillen in de meeste gevallen nauwelijks zichtbaar zijn, maar de prestaties tot soms wel 10 tot 15% vooruit gaan. Opvallend genoeg zijn er echter ook benchmarks die aantonen dat de optimalisaties het spel juist trager maken, maar dat is iets wat vooral voorkomt op de oudere R3xx-chips.

De conclusie is dat ATi waarschijnlijk een goede zet gedaan heeft door de eindgebruiker de mogelijkheid te geven om al dan niet te kiezen voor optimalisaties. Zowel fps-freaks als pixel-puristen kunnen zo aan hun trekken komen. Bovendien geeft het meer vertrouwen in het bedrijf, omdat niemand meer hoeft te raden naar welke trucs er op een bepaald moment uitgehaald worden. Het dilemma zal vooral komen te liggen bij de reviewers die moeten gaan kiezen welke instelling ze gebruiken tijdens hun tests, nu het niet langer de keus van de fabrikant maar van de eindgebruiker is om omstreden methodes te gebruiken om betere prestaties neer te zetten.