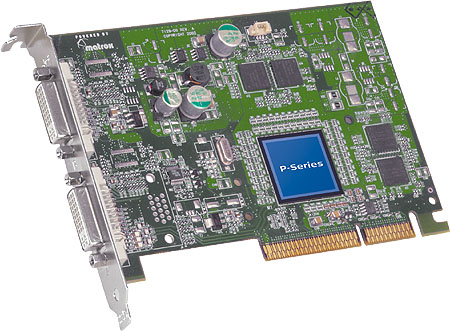

Bij Icrontic is een review verschenen over de laatste videokaart van Matrox, de P750. Deze videokaart is een budget-versie van de Parhelia en hoewel er DirectX 8.1 ondersteuning aanwezig is, is de kaart niet bedoeld voor gamers. Matrox mikt op de 2D-workstationmarkt en dankzij een prijskaartje van 235 dollar is de kaart een betere keus dan de Parhelia als je niet geïnteresseerd bent in 3D-prestaties. De reviewer is positief over de kaart, maar mensen die met 3D-applicaties werken kunnen beter verder kijken naar een andere kaart:

The casual gamer will be able to enjoy the latest games but with a few concessions. I recommend Matrox products for multi-monitor environments but would obviously hesitate for gaming enthusiasts and 3D designers who require massive GPU processing power. 2D graphic enthusiasts will love the flexibility and no-hassle desktop that Matrox provides.

I can't help but respect Matrox for their multi-monitor expertise. I work on multi-monitor computers day in and day out. G450/G550 lovers who are looking for an upgrade will be very pleased with the Millennium P650 or P750 and especially pleased with the price point in comparison to the Parhelia. Matrox have targeted productivity enthusiasts and once you go dual (or even triple) you won't go back.