Futuremark heeft op haar site een reactie neergezet op de kritiek die onder aanvoering van nVidia verscheen op 3DMark03 na de lancering van deze benchmark. Als eerste haast Futuremark te zeggen dat 3DMark03 bedoeld is om de prestaties van DirectX 9 hardware te testen met benchmarks die qua complexiteit overeenkomen met die van toekomstige DirectX 9 games. Voor het testen van DirectX 7 of de eerste generatie DirectX 8 kaarten raad Futuremark het gebruik van 3DMark 2001 aan.

In het document wordt onder andere het gebruik van alleen pixelshaders v1.1 en v1.4 verdedigd. Het is belangrijk dat een goede benchmark, onafhankelijk van de videokaart, elke scene exact hetzelfde tekent op de meest efficiënte methode. Als er ondersteuning aanwezig is voor pixelshaders 1.4, wat het geval is bij alle DirectX 9 hardware, wordt dit gebruikt om de scene te renderen aangezien het de enige manier is waarop single pass per light rendering geïmplementeerd kan worden. Als er geen gebruik gemaakt wordt van een DirectX 9 videokaart, maar van een DirectX 8 videokaart zonder ondersteuning voor pixelshaders v1.4, wordt er overgeschakeld naar pixelshaders v1.1 om de scene te tekenen. Het gebruik van pixelshaders v1.2 of v1.3 zou geen enkel voordeel hebben geboden boven v1.1 en worden daarom niet gebruikt.

In het document wordt onder andere het gebruik van alleen pixelshaders v1.1 en v1.4 verdedigd. Het is belangrijk dat een goede benchmark, onafhankelijk van de videokaart, elke scene exact hetzelfde tekent op de meest efficiënte methode. Als er ondersteuning aanwezig is voor pixelshaders 1.4, wat het geval is bij alle DirectX 9 hardware, wordt dit gebruikt om de scene te renderen aangezien het de enige manier is waarop single pass per light rendering geïmplementeerd kan worden. Als er geen gebruik gemaakt wordt van een DirectX 9 videokaart, maar van een DirectX 8 videokaart zonder ondersteuning voor pixelshaders v1.4, wordt er overgeschakeld naar pixelshaders v1.1 om de scene te tekenen. Het gebruik van pixelshaders v1.2 of v1.3 zou geen enkel voordeel hebben geboden boven v1.1 en worden daarom niet gebruikt.

Verder legt Futuremark uit waarom:

- Er gebruik gemaakt wordt van single texturing voor de sky box in game test 1

- Er gebruik gemaakt wordt van dezelfde rendering techniek voor game test 2 en 3.

- Er gebruik gemaakt wordt van vertex shader skinning in plaats van CPU skinning.

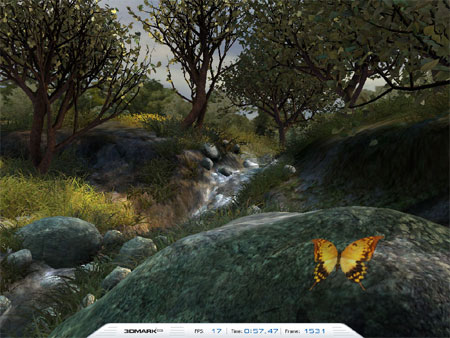

- Er in game test 4 alleen voor het water en de lucht pixelshaders v2.0 gebruikt worden.

Ook ATi heeft gemeend niet achter kunnen blijven en hier gereageerd op de kwestie.

:strip_exif()/i/1045000502.jpg?f=fpa)