Het zal je niet ontgaan zijn: nVidia heeft vandaag haar eerste chipset officieel geïntroduceerd. Dat is natuurlijk niet onopgemerkt voorbij gegaan bij de verschillende hardware sites en die hebben dan ook allemaal een stukje neergezet over de nForce. Zo kan je bij Digit-Life, Tom's Hardware, SocketA.com en nV News terecht als graag het fijne wilt weten van deze chipset.

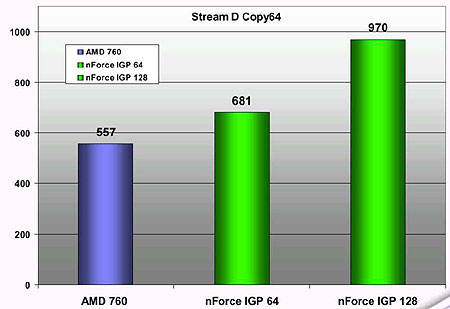

Verder is er bij Penstar Systems een preview verschenen waar ook een paar benchmarks in te vinden zijn. De benchmarks komen van nVidia vandaan en laten indrukwekkende resultaten zien. In Stream D benchmark is de nForce chipset met een 64-bit interface naar het geheugen 20% sneller dan de AMD760 chipset en met een 128-bit interface is dit zelfs 75%. Logischerwijs zien de mannen van Penstar Systems deze chipset wel zitten ![]() :

:

NVIDIA is going to take over the world. So far reports on this chipset have been very positive in real world settings, and the overwhelming specs that NVIDIA included in this product are mind-boggling! This product is literally 2 years ahead of its time, and NVIDIA was able to complete it in slightly over a year. This is not bad for a company with no prior experience in the core logic market.

While I don’t have a board in my possession, nor have I seen any 3rd party numbers coming out of this board, I feel that it will perform up to expectations, and may in fact surpass these expectations. When I originally heard NVIDIA was going to develop a core logic chipset, I didn’t think they could pull it off, or at least be able to match the performance of other products at the time of release. Currently it looks as if the nForce will rule with an iron fist from top to bottom.

The extra bandwidth provided by the dual channel DDR memory controller, as well as that afforded by the HyperTransport protocol will not go unwasted. When all processors are working at full speed, that extra bandwidth will be needed and much appreciated. As digital content becomes more and more complex, older architectures will be left far behind when dealing with the huge overall bandwidth that this product has.

|

Onze dank gaat uit naar EaS, FlipFlap, GiGNiC en tigger voor tips!