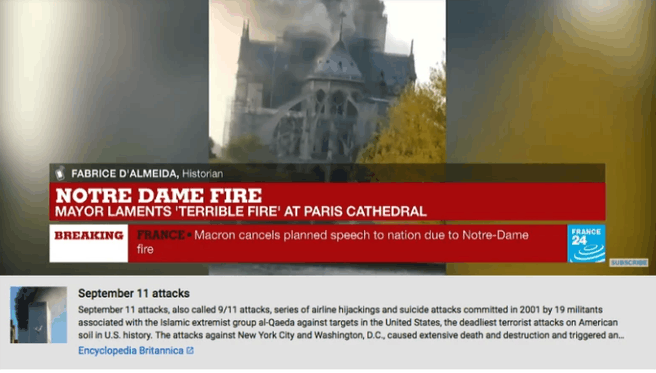

Het algoritme van YouTube zag livestreams van de Notre-Dame-brand maandagavond als nepnieuws. Bij de video verscheen bovendien een artikel over de terroristische aanval op de Twin Towers van het WTC op 11 september 2001.

Een woordvoerder van YouTube gaf aan Buzzfeed toe dat het algoritme verkeerd schatte welke video's een melding moesten krijgen. Tijdens de livestreams van de brand van de Notre-Dame kregen gebruikers een pop-up met een artikel over de terroristische aanval op het World Trade Center in 2001. YouTube verwijderde de melding na enkele minuten, maar toch was er al een aantal Twitter-gebruikers dat hierover berichtte.

De functie van YouTube waarbij gebruikers 'topical context' krijgen te zien, is onderdeel van een groter geheel om ervoor te zorgen dat mensen minder met nepnieuws in aanraking komen. De videosite wil verder het aanbod van lokaal nieuws vergroten en gebruikers meer naar publicaties van grote nieuwsuitgevers sturen.

Veel gebruikers van socialemediakanalen als Facebook en YouTube streamden beelden van de Notre-Dame-brand van maandagavond, toen een aanzienlijk gedeelte van het Franse monument in vlammen opging. De oorzaak van de brand is nog niet duidelijk, maar het lijkt te gaan om een ongeluk tijdens de renovatie van de kathedraal.

/i/1316076409.png?f=fpa)

/i/1260956366.png?f=fpa)

/i/1289644242.png?f=fpa)

:strip_exif()/i/2001073909.jpeg?f=fpa)