Twee weken na de benchmarks van de GeForce GTX 1080 zijn de resultaten van de GTX 1070 verschenen. Deze goedkopere nieuwe GeForce-kaart in de 1000-serie blijkt sneller dan een Titan X en meer dan 50 procent sneller dan de GTX 970, met een lager verbruik dan die laatste.

De introductie van de GTX 1070 is een stuk logischer dan die van de GTX 1080, meent Guru3D. De adviesprijs van de GTX 1070 Founder's Edition bedraagt 499 euro en die van de kaarten met alternatieve koelers en pcb start bij 430 euro. Die prijzen liggen hiermee in de buurt van de voorgaande vlaggenschepen van Nvidia, waar de GTX 1080 met zijn prijzen rond 800 euro daarboven ligt. De GTX 1070 spreekt daarmee potentieel een groter publiek aan.

Bij elke test die Tom's Hardware draaide, blijkt de GTX 1070 sneller dan de GTX Titan X, een kaart die bij introductie meer dan 1100 dollar kostte. Bij de benchmarks van Hexus presteert de nieuweling gemiddeld op 80 procent van de resultaten van de GTX 1080 en iets beter dan de GTX 980 Ti. Ook bij de prestatieindex van SweClockers neemt de GTX 1070 comfortabel een plek in boven de Titan X en GTX 980 Ti.

PC Perspective benadrukt nog wel dat AMD zich met zijn Polaris-kaarten op het segment rond 299 dollar gaat richten en daarmee mogelijk een geduchte concurrent van deze kaart uitbrengt, al is dit speculatie. De GTX 1070-kaart komt tot deze prestaties met een verbruik dat ruim onder dat van de GTX 1080 ligt en dat iets onder dat van de GTX 970 ligt, ondervond onder andere Hardware Canucks. Ook Legit Reviews kwam bij een meting tot een laag verbruik al tekent de site aan dat dit sterk afhankelijk was van de resolutie.

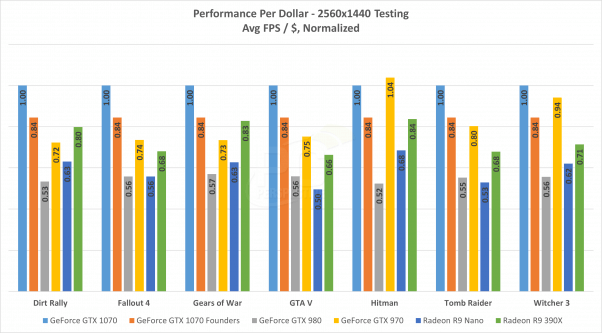

Het performance-per-dollar-overzicht van de GTX 1070 volgens Pc Perspective.

Het performance-per-dollar-overzicht van de GTX 1070 volgens Pc Perspective.

De GTX 1070 Founders Edition beschikt over dezelfde koeler als zijn grote broer en ook zijn drie displayports, hdmi en duallink-dvi aanwezig. Verschil is er bij het geheugen: er is 8GB gddr5 in plaats van het snellere gddr5x van de GTX 1080 aanwezig. De GP104-gpu is uiteraard ook aangepast. Er is ten opzichte van de gpu bij de GTX 1080 een gpc, en daarmee vijf sm's, uitgeschakeld. Dat resulteert in 1920 shaders, waar de GTX 1080 er 2560 heeft. Verder is er een vier- in plaats van vijffasige stroomvoorziening en bedraagt de tdp 150W tegenover 180W voor de GTX 1080.

Vanaf 10 juni komt de kaart beschikbaar, maar meerdere reviewsites tekenen aan dat de kans bestaat dat het de vraag is of er voldoende voorraden zijn tegen die tijd.

| Videokaart | GTX 970 | GTX 980 | GTX 980 Ti | GTX 1070 | GTX 1080 |

|---|---|---|---|---|---|

| Gpu | GM204 | GM204 | GM200 | GP104-200 | GP104-400 |

| Procedé | 28nm | 28nm | 28nm | 16nm finfet | 16nm finfet |

| Transistors | 5,2 miljard | 5,2 miljard | 8 miljard | 7,2 miljard | 7,2 miljard |

| Sm's | 13 | 16 | 22 | 15 | 20 |

| Cudacores | 1664 | 2048 | 2816 | 1920 | 2560 |

| Tmu's | 104 | 128 | 176 | 120 | 160 |

| Rop's | 56 | 64 | 96 | 64 | 64 |

| Baseclock | 1050MHz | 1126MHz | 1000MHz | 1506MHz | 1607MHz |

| Boostclock | 1178MHz | 1216MHz | 1075MHz | 1683MHz | 1733MHz |

| Vram | 4GB gddr5 | 4GB gddr5 | 6GB gddr5 | 8GB gddr5 | 8GB gddr5x |

| Geheugenbus | 256bit | 256bit | 384bit | 256bit | 256bit |

| Bandbreedte | 224GB/s | 224GB/s | 336,5GB/s | 256GB/s | 320GB/s |

| Tdp | 145W | 165W | 250W | 150W | 180W |

| Stroom- aansluiting |

2x 6pins | 2x 6pins | 6pin+8pin | 1x 8pins | 1x 8pins |

Vergelijking van de nieuwe Pascal-videokaarten met de op Maxwell gebaseerde GeForce 9XX-generatie.

Update, 12.35: Afbeelding van Legit Reviews verwijderd wegens onduidelijkheid verbruik videokaart versus verbruik hele systeem.

:strip_exif()/i/2001087245.png?f=thumbmedium)

:strip_icc():strip_exif()/i/2001130331.jpeg?f=fpa_thumb)

/i/2000820476.png?f=fpa)

/i/1364304260.png?f=fpa)

/i/1397132571.png?f=fpa)