Tweakers.net heeft op zaterdagochtend 24 oktober een nieuwe databaseserver in gebruik genomen. De upgrade ging gepaard met een downtime van iets meer dan drie uur.

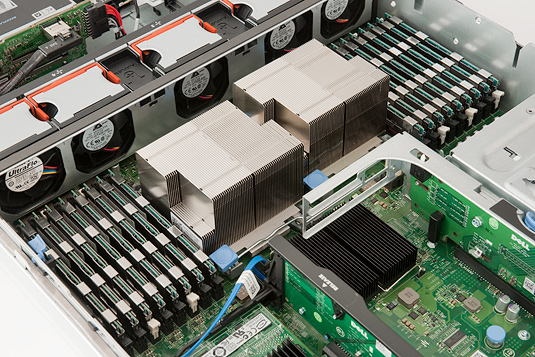

De huidige database-servers van het forum en de frontpage, bij jullie allen bekend als Apollo en Artemis, zijn inmiddels de leeftijd van respectievelijk drie en twee jaar gepasseerd en dus werd het tijd om beide machines van hun oude dag te laten genieten als dev- en replicatieserver. Onze technische mannen werden wederom belast met de taak om een zo ontzagwekkend mogelijke configuratie uit te zoeken. Dat is gelukt door een Dell PowerEdge R710 vol te douwen met 72GB geheugen, zes 50GB solid state drives en twee quadcore Xeon X5570-processors met een kloksnelheid van 2,93GHz. Het apparaat werd afgetankt met twee 300GB sas-schijven, die opslag zullen bieden voor het besturingsssyteem en de binary logs van MySQL.

Na de ingebruikname van het nieuwe datamonster zal de gehele website met uitzondering van een aantal ondersteunende databases weer op een enkele databaseserver komen te draaien. De MySQL-databases van de frontpage en het forum werden acht jaar geleden uit elkaar getrokken omdat de betaalbare hardware van toen niet in staat was de onstuitbare groei van de site bij te benen. Artemis 1 kreeg in mei 2001 gezelschap van Apollo, een machine met twee 1,0GHz Pentium III-processors, 1,5GB geheugen en twee 18GB Quantum Atlas 10K II-disks. Tegenwoordig maak je hooguit een netbook bang met deze specs maar destijds werden ze geprezen vanwege de hoge kwijlbaarheidsfactor.

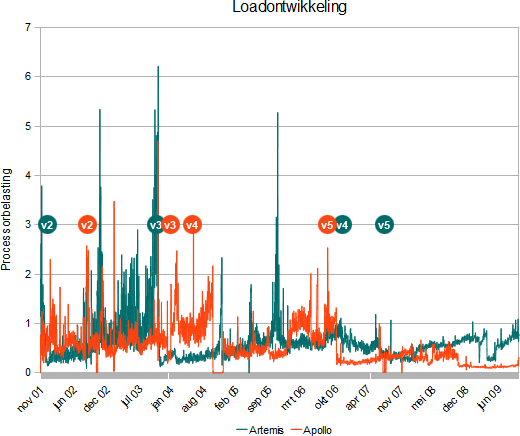

Door de opkomst van multi-core processors en solid state drives en het bijna gratis weggeven van geheugen zijn de prestaties van betaalbare serversystemen de afgelopen jaren veel sneller gegroeid dan er nieuwe tweakers werden geproduceerd. Ongehinderd door deze wetenschap leefden de devvers zich bovendien uit op het bouwen van performance-optimalisaties zoals de inzet van memcached, Active MQ en de op Java gebaseerde middleware voor de Pricewatch. De belasting van de databaseservers ging omlaag in plaats van omhoog en dus was performance geen reden meer om de databases gescheiden te houden. Vanuit praktisch oogpunt was de scheiding vaak aan een blok aan ons devvende been.

In geest met de tijd worden de zwaarlijvige configuraties van de huidige Artemis en Apollo fors gedownsized. De huidige machines bezetten ieder 4U aan rackspace door het gebruik van een 1U Dell PowerEdge 1950 in combinatie met een 3U PowerVault MD1000 disk-array. De MD1000 is bij beide machines gevuld met vijftien energieslurpende 15.000 toeren harde schijven in 3,5 inch formaat. Het nieuwe systeem neemt genoegen met een bescheiden 2U aan rackspace en draait dankzij de zes geruisloze solid state drives rondjes om de I/O-prestaties van de harddisk-arrays. Artemis 5 is na de eerder dit jaar geplaatste zoekmachine onze tweede server die is uitgerust met ssd's.

De initiatie van Artemis 6 en de hereniging van de databases zal aanvangen op 24 oktober rond 7.00 uur. Zowel het forum als de frontpage zullen bij het kopiëren van de databases onklaar gemaakt worden. Verwacht wordt dat het onderhoud zo'n vier uur in beslag zal nemen. Tegen de tijd dat je goed en wel bent uitgeslapen zijn wij dus al lang weer up and running.

Hieronder volgt een overzicht van oude hardware die jullie met je postgedrag versleten hebben.

| Artemis 1 (06-12-2000) | Apollo 1 (15-06-2001) | |

|---|---|---|

| Processors | 2x Pentium III 733MHz - 1,0GHz | 2x Pentium III 1,0GHz |

| Geheugen | 1,5GB - 4GB PC133 SDR | 2GB - 4GB PC133 SDR |

| Raid-controller | AMI MegaRAID Elite 1500 | Adaptec ASR-3200S |

| Opslag | 1x 20GB ata 3x Seagate Cheetah X15 18GB |

2x Quantum Atlas 10K II 18GB |

| Artemis 2 (14-12-2001) | Apollo 2 (31-08-2002) | |

| Processors | 2x Athlon MP 1600+ 1,4GHz | 2x Athlon MP 1900+ 1,6GHz |

| Geheugen | 2GB DDR-266 | 3,5GB DDR-266 |

| Raid-controller | Adaptec ASR-3200S | Adaptec ASR-3200S |

| Opslag | 1x 20GB ata 5x Seagate Cheetah X15 18GB |

1x 20GB ata 5x Seagate Cheetah 36XL 36GB |

| Artemis 3 (01-11-2003) | Apollo 3 (20-12-2003) | |

| Processors | 2x Opteron 246 2,0GHz | 2x Opteron 242 1,6GHz |

| Geheugen | 4GB DDR-266 | 6GB DDR-266 |

| Raid-controller | LSI MegaRAID Elite 1600 | LSI MegaRAID Elite 1600 |

| Opslag | 2x Seagate Cheetah 18XL 9GB 4x Seagate Cheetah 10K.6 36GB |

6x Seagate Cheetah 10K.6 36GB |

| Artemis 4 (17-11-2006) | Apollo 4 (17-05-2004) | |

| Processors | 2x Opteron 254 2,8GHz | 2x Opteron 244 (1,8GHz) |

| Geheugen | 8GB DDR-333 | 8GB DDR-333 |

| Raid-controller | LSI MegaRAID SCSI 320-2X | LSI MegaRAID SCSI 320-2X |

| Opslag | 2x Seagate Cheetah 10K.6 36GB 6x Seagate Cheetah 15K.3 36GB |

2x Seagate Cheetah 10K.6 36GB 6x Seagate Cheetah 15K.3 36GB |

| Artemis 5 (28-07-2007) | Apollo 5 (01-09-2006) | |

| Processors | 2x Xeon X5355 2,66GHz | 2x Xeon 5160 3,0GHz |

| Geheugen | 16GB DDR2-667 | 16GB DDR2-667 |

| Raid-controller | Dell Perc 5/i Dell Perc 5/e |

Dell Perc 5/i Dell Perc 5/e |

| Opslag | 2x Seagate Savvio 10K.2 73GB 15x Seagate Cheetah 15K.5 73GB |

2x 73GB 10K SAS 15x Fujitsu MAX3036RC 36GB 15K SAS |

| Artemis 6 (24-10-2009) | ||

| Processors | 2x Xeon X5570 2,93GHz | |

| Geheugen | 72GB DDR3-800 | |

| Raid-controller | Dell Perc 6/i | |

| Opslag | 2x Seagate Savvio 10K.3 300GB 6x Dell / Samsung MCCOE50G5MPQ 50GB |

|

Update 10:15: De upgrade is vrijwel probleemloos verlopen en wij zijn weer up and running!