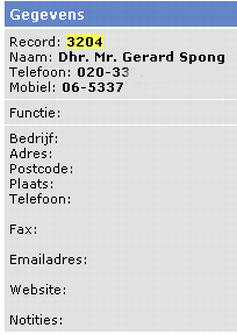

De GPD, de persdienst van de Nederlandse regionale kranten, heeft via Google abusievelijk de telefoonnummers van vele bekende Nederlanders gepubliceerd. In de database staan onder meer Geert Wilders, Mart Smeets en Gerard Spong.

Een GPD-webserver die voor een intranet bedoeld is maar toch via het internet bereikbaar blijkt te zijn, biedt toegang tot een database met duizenden telefoonnummers van bekende en minder bekende Nederlanders. De journalisten van de GPD - de dienst die voor veel Nederlandse regionale kranten nieuws en achtergrondverhalen maakt - maken gebruik van de database om telefoonnummers van contactpersonen te zoeken en op te slaan.

De GPD-database omvat duizenden telefoonnummers en andere privé-gegevens van politici, journalisten, presentatoren en andere bekende Nederlanders. Zo zijn er de actuele telefoonnummers van onder meer Geert Wilders, Jort Kelder, Frits Wester, Mart Smeets, Felix Meurders en Gerard Spong in te vinden. De meeste van hen reageerden verbaasd dat hun telefoonnummer zomaar vindbaar is. Veel entry's zijn echter verouderd, zoals die van premier Jan-Peter Balkenende en Marco Borsato.

Het vinden van de database is niet moeilijk: het uitvoeren van een Google-zoekopdracht met 'site:' en het ip-adres van een GPD-site is afdoende om een lijst met telefoonnummers te krijgen. De site is weliswaar via een login afgeschermd, maar in de tekst van de zoekresultaten en via de Google-cache zijn vrijwel alle gegevens zichtbaar. Normaal wordt een dergelijke database afgeschermd door via een whitelist alleen bepaalde ip-adressen toegang te geven en worden spiders van zoekmachines als Google geweerd met het gebruik van een robots.txt-bestand.

De GPD is verbaasd over het lek dat Tweakers.net ontdekte. "Het is natuurlijk niet de bedoeling dat mensen zomaar in onze database van contactpersonen kunnen kijken", aldus een woordvoerster van het persbureau. "Een extern bureau onderhoudt de webserver voor ons." Inmiddels is het intranet op de webserver niet meer bereikbaar, de zoekresultaten en de pagina's in cache zijn nog altijd zichtbaar.

Update, 20.45 uur, de cache van Google lijkt inmiddels geleegd

/i/2000632587.png?f=fpa)

/i/1288947414.png?f=fpa)

:strip_exif()/i/1308816137.gif?f=fpa)

:strip_exif()/i/1278154011.jpeg?f=fpa)

:strip_exif()/i/1263563744.gif?f=fpa)

/i/1259154622.png?f=fpa)

:strip_exif()/i/1075045873.jpg?f=fpa)

:strip_exif()/i/1159803170.gif?f=fpa)

:strip_exif()/i/1195226092.gif?f=fpa)

:strip_exif()/i/1124121765.gif?f=fpa)

:strip_exif()/i/1147300996.gif?f=fpa)