De Turing Award voor 2007 is toegekend aan Edmund M. Clarke, E. Allen Emerson en Joseph Sifakis voor hun onderzoek op het gebied van model checking. Aan de award is prijzengeld van 250.000 dollar verbonden.

De prestigieuze prijs, die officieus te boek staat als de Nobelprijs voor de informatica, is toegekend aan de drie vanwege hun baanbrekend werk op het gebied van opsporingstechnologie voor hard- en softwarefouten. "Zonder de conceptuele doorbraak van deze onderzoekers zouden we nog steeds zitten met chips vol fouten en trage systemen", aldus Stuart Feldman, president van de ACM die de Turing Awards uitreikt. Clark van de Carnegie Mellon-universiteit en zijn voormalige student Emerson van de University of Texas in Austin werkten samen aan het onderzoek, terwijl Sifakis van de universiteit van Grenoble eigen onderzoek deed.

De prestigieuze prijs, die officieus te boek staat als de Nobelprijs voor de informatica, is toegekend aan de drie vanwege hun baanbrekend werk op het gebied van opsporingstechnologie voor hard- en softwarefouten. "Zonder de conceptuele doorbraak van deze onderzoekers zouden we nog steeds zitten met chips vol fouten en trage systemen", aldus Stuart Feldman, president van de ACM die de Turing Awards uitreikt. Clark van de Carnegie Mellon-universiteit en zijn voormalige student Emerson van de University of Texas in Austin werkten samen aan het onderzoek, terwijl Sifakis van de universiteit van Grenoble eigen onderzoek deed.

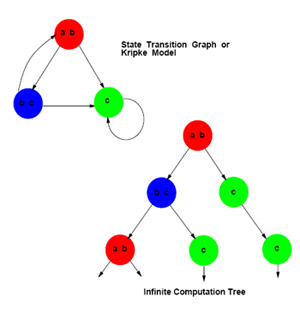

Met model checking worden de mogelijke statussen van een hardware- of software-ontwerp doorlopen om te bepalen of het consistent is met de specificaties van de ontwerper. Clarke en Emerson ontwikkelden de theorie in 1981 aan de universiteit van Harvard. Hun systeem kon bij het niet voldoen aan een specificatie ook de bron van het probleem aangeven.

De eerste implementatie van de theorie volgde in 1982, maar deze kon maar kleine chipontwerpen verifieren. Pas met de implementatie van model checking via binaire beslissingsbomen en de mogelijkheid om symbolische informatie op basis van modale logica in het systeem te verwerken, kon het systeem ook zeer complexe systemen verifiëren en was het relevant geworden om op brede schaal in te zetten bij computerontwerpen. Ook Microsoft gebruikt een vorm van model checking als onderdeel van haar SLAM-project om betere code op te leveren.

:strip_exif()/i/1171451201.gif?f=fpa)

:strip_exif()/i/2000593713.jpeg?f=fpa)

/i/1349799363.png?f=fpa)

/i/1299717163.png?f=fpa)

/i/1268250664.png?f=fpa)

:strip_exif()/i/1236716187.gif?f=fpa)

/i/1200408445.png?f=fpa)

/i/1218702793.png?f=fpa)