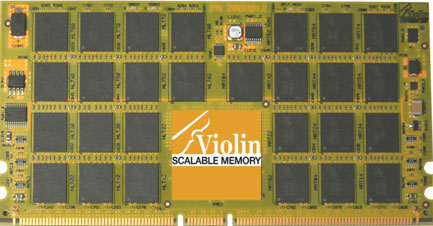

Het startende bedrijf Violin heeft hardware ontwikkeld waarmee tot 504GB geheugen in een 2U-server gestopt kan worden. Deze 'memory appliance' kan via een HyperTransport-verbinding aan een Opteron-server worden geknoopt.

Door een heel 19"-rack vol te bouwen met dit soort machines kan er tot 10TB geheugen geplaatst worden, wat bijvoorbeeld nuttig kan zijn voor hele grote databases. Daar moet dan wel grof geld voor neergeteld worden: alleen de 120GB 'starter kit' kost namelijk al 50.000 dollar.

Via software kan gekozen worden om data in het snelle lokale geheugen te plaatsen of in het enorme 'extended memory', dat een stuk trager is maar nog steeds sneller werkt dan een harde schijf. Door de virtuele geheugenbanken in een raid-opstelling te zetten kan de betrouwbaarheid en snelheid van het systeem verder verhoogd worden. Violin hoopt de eerste systemen in de tweede helft van 2008 te kunnen leveren.

Update (10:40) Zoals opgemerkt in de reacties bestaat er nu al een versie van het systeem dat inhaakt op pcie, wat het ook toepasbaar maakt voor Intel-machines. De AMD HyperTransport-versie zou wel extra voordelen bieden, zoals een lagere latency en cache-coherentie.

:strip_exif()/i/1158923781.jpg?f=fpa)

/i/1160051138.png?f=fpa)

:strip_exif()/i/1189419555.gif?f=fpa)

:strip_exif()/i/1187160107.jpg?f=fpa)

:strip_exif()/i/1181810633.jpg?f=fpa)