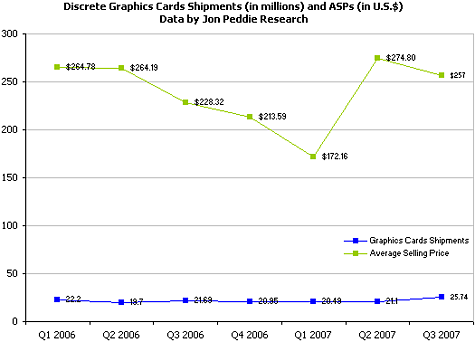

Een marktonderzoek van Jon Peddie Research laat zien dat het derde kwartaal van 2007 een topkwartaal was voor de losse desktopvideokaarten. Ten opzichte van hetzelfde kwartaal vorig jaar groeide het aantal verkochte kaarten met 18,7 procent.

De sterke groei van de verkopen is opmerkelijk omdat de markt onder druk staat door de toenemende populariteit van geïntegreerde graphics. Volgens Jon Peddie Research zijn de toegenomen verkopen te danken aan de introductie van Windows Vista eerder dit jaar. Veel mensen hebben een DirectX 10-videokaart aangeschaft.

Ten opzichte van het derde kwartaal vorig jaar is ook de gemiddelde verkoopprijs gestegen, van 228 naar 257 dollar. Ten opzichte van een half jaar geleden is het echter een nog sterkere stijging: toen ging een videokaart voor gemiddeld 172 dollar over de toonbank. Door de toegenomen vraag naar high-end DirectX 10-videokaarten is de gemiddelde verkoopprijs in het tweede kwartaal van 2007 sterk gestegen.