AMD zal morgen een toolkit uitbrengen die softwareontwikkelaars in staat stelt om de mogelijkheden van AMD's virtualisatietechnologie 'Pacifica' te verkennen, schrijft StoragePipeline. 'SimNow', zoals het product is gedoopt, is een processorsimulator die met de Pacifica-code is uitgerust, zodat developers zich vertrouwd kunnen maken met de ontwikkelomgeving van AMD's volgende generatie cpu's. Chips met Pacifica-ondersteuning worden begin volgend jaar op de markt verwacht. 'Ontwikkelaars hebben zo de hardware niet nodig om toch te kunnen zien hoe de technologie gebruikt kan worden en toepassingen te bouwen', aldus Margaret Lewis van AMD. Ook Intel zal naar verwachting volgend jaar met zijn Vanderpool-virtualisatietechniek komen. Beide fabrikanten verwachten dat de processorsupport nodig is om efficiënter en veiliger virtuele procesomgevingen te creëeren. Momenteel is de gebruiker die meer besturingssystemen simultaan wil draaien nog aangewezen op softwarematige oplossingen van onder meer Microsoft en VMware.

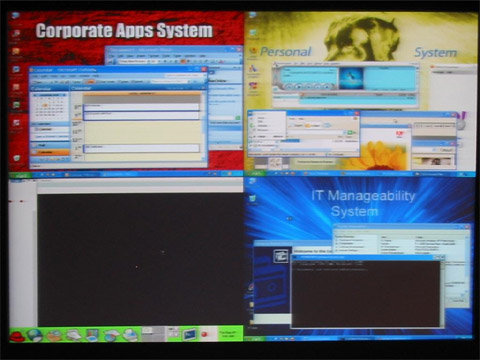

/i/1195378013.png?f=fpa)