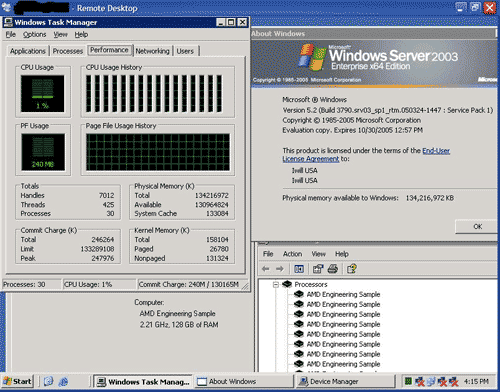

Iwill gaat komende week op de Computex-beurs in Taiwan een Opteron-server met zestien cores demonstreren. De H8502 maakt gebruik van acht 2,2GHz dual-core Opteron 875-chips en is in totaal voorzien van 128GB RAM (vier 4GB-reepjes per socket). Het 'moederbord' van de server is opgebouwd uit zes aparte printplaten: een systeembord, I/O-bord en vier aparte processor/geheugenborden. De Opterons in de server worden via hun eigen HyperTransport-controllers aan elkaar geknoopt, maar voor de verbinding met het I/O-bord - waar zaken als SATA en USB 2.0 op zitten - wordt HTX gebruikt. Extended64 heeft een aantal screenshots online gezet die zijn gemaakt op deze indrukwekkende machine. Naast enkele zaken als een overbevolkte Windows Task Manager zijn er ook een paar benchmarks op uitgevoerd, namelijk SiSoft Sandra en ScienceMark. Hoewel dit vrij nietszeggende tests zijn is het voor de ware nerd wellicht leuk om de extreme verschillen te zien met de 'simpele' 2-core en 4-core systemen.