Nvidia heeft in het laatste kwartaal van 2018 veel minder gpu's verkocht dat in datzelfde kwartaal een jaar eerder. De omzet daalde met 24 procent. Dat komt omdat mensen minder gpu's kopen voor het delven van cryptocurrency en omdat de RTX-videokaarten niet aanslaan.

Nvidia bevestigt bij de bekendmaking van zijn kwartaalcijfers nog eens dat de verkoop van high-end RTX-videokaarten niet is wat het bedrijf ervan had verwacht. Dat blijkt uit een transcriptie van het gesprek met investeerders na de presentatie. Concrete cijfers over aantallen videokaarten geeft Nvidia niet, maar het bedrijf zegt dat onder andere de RTX 2080 en 2070 het niet zo goed hebben gedaan als gehoopt.

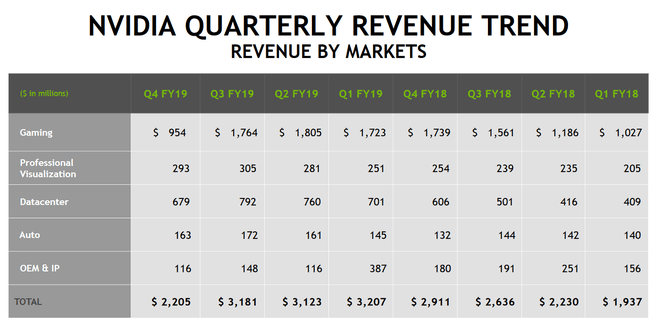

De Gaming-divisie behaalde een omzet van 954 miljoen dollar, een daling van 45 procent ten opzichte van een jaar eerder en een daling van 46 procent ten opzichte van het vorige kwartaal. Ook daalde de omzet bij de OEM & IP-divisie, waar de verkopen van socs voor consoles onder vallen. Het ging wel goed bij de divisies Datacenter, Automotive en Professional Visualisation, die allemaal meer omzet behaalden dan een jaar geleden. De Gaming-divisie is echter verreweg het grootst en de sterke daling daar heeft veel invloed op de cijfers.

Eind januari stelde Nvidia zijn verwachtingen al naar beneden bij. Als verklaring gaf Nvidia toen al onder meer de tegenvallende verkopen van videokaarten met de nieuwe Turing-architectuur. Ceo Jensen Huang zei toen dat consumenten wellicht wachten tot de RTX-kaarten goedkoper zijn, of dat ze wachten op meer ondersteuning voor raytracing in games.

De omzet in de laatste drie maanden van 2018 bedroeg 2,21 miljard dollar, 24 procent minder dan in hetzelfde kwartaal een jaar eerder. De nettowinst bedroeg 567 miljoen dollar, een daling van 49 procent. De cijfers over heel 2018 waren wel hoger dan die van een jaar eerder. De jaaromzet kwam uit op 11,72 miljard dollar, een stijging van 21 procent. Dat komt omdat er aan het begin van het jaar nog veel videokaarten werden verkocht, mede dankzij de hype rondom cryptocurrency.

:fill(white):strip_exif()/i/2002444728.jpeg?f=thumbmedium)

:strip_exif()/i/2002170191.png?f=thumbmedium)

:strip_icc():strip_exif()/i/2002663394.jpeg?f=fpa_thumb)

:strip_exif()/i/2002170193.png?f=thumbmedium)

:strip_exif()/i/2002170195.png?f=thumbmedium)

:strip_exif()/i/2002463806.jpeg?f=fpa)

/i/2000820476.png?f=fpa)

/i/1332001706.png?f=fpa)

/i/2001507509.png?f=fpa)

:strip_exif()/i/2002162309.jpeg?f=fpa)

/i/2001507511.png?f=fpa)