Volgens Seagate ligt de ontwikkeling van zijn hamr-technologie voor harde schijven op schema en kan de eerste hamr-hdd in de eerste helft van dit jaar op de markt komen. Seagate werkt al jaren aan de techniek.

De ceo van Seagate, Dave Mosley, meldde dat de productie opgevoerd gaat worden nadat partners de eerste producten valideren. Volgens Seagate voldoen de onderdelen van de hamr-hdd's aan de vereisten die datacenters stellen en media en schrijfkoppen kunnen tot 4PB per kop afhandelen. Dat schrijft AnandTech.

In een eerder blog benadrukte Seagate al de langetermijnprestaties van de hamr-lees- en schrijfkoppen, die de eisen van klanten met een factor twintig zouden overstijgen. Toen zei het bedrijf ook dat de opslagdichtheid 2,381 terabit per vierkante inch is en de opslagdichtheid van hamr die van reguliere hdd-technieken overstijgt.

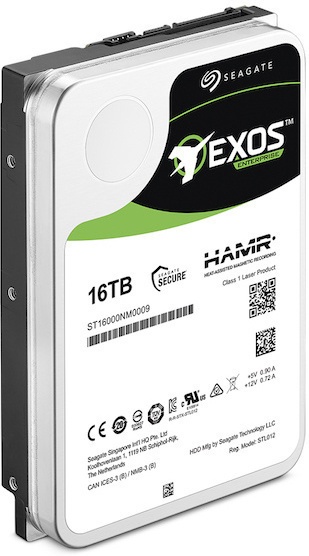

Seagate werkt al vele jaren aan hamr, wat staat voor heat-assisted magnetic recording. Hierbij worden de magnetische gebieden waar data wordt opgeslagen onder verhitting van een laser gedemagnetiseerd en weer gemagnetiseerd. Daardoor kan data makkelijker geplaatst worden. De techniek moet voor hogere datadichtheid zorgen. Het eerste product is een 3,5"-hdd in de Exos-lijn voor de enterprisemarkt, met in totaal 16 TB aan opslag, maar de volgende generatie gaat tot 24TB.

Later dit jaar moeten ook de eerste 14TB-hdd's met twee actuatoren verschijnen. Deze bieden sequentiële leessnelheden van 500MB/s.

:strip_icc():strip_exif()/i/2003960096.jpeg?f=fpa_thumb)

/i/2001766573.png?f=fpa)

:strip_exif()/i/2001753235.jpeg?f=fpa)

:strip_exif()/i/1275386826.jpeg?f=fpa)

/i/1271057694.png?f=fpa)