Intel blijft grote monolithische processors ontwikkelen om het core-aantal te verhogen. Volgens het bedrijf zorgt het aan elkaar plakken van dies voor latency, waarbij Intel lijkt te verwijzen naar AMD's aanpak.

Het vergroten van het aantal cores op een monolithische processor heeft het voordeel van een lagere latency, vertelt Guy Therien, chief architect bij de Intel Client Computing Group voor het performance-segment. Van die latency 'heb je gehoord bij de aanpak om een groot aantal cores te verkrijgen', aldus de chiparchitect. Daarmee lijkt Therien te verwijzen naar AMD, die bij zijn Threadripper- en Epyc-processors vier dies verbindt om tot maximaal 32 cores te komen. In presentaties benadrukte Intel al eerder het verschil in die-to-die latency tussen zijn aanpak van monolithische Xeon-processors en AMD's methode.

Volgens Therien zorgt Intels methode voor consistentere prestaties. Verder benadrukt hij dat voor de meeste consumenten, meer cores niet altijd beter zijn omdat de meeste applicaties er toch niet van gebruikmaken. "Als je niet meer cores nodig hebt, kan het zelfs negatief uitpakken omdat meer cores meer hitte betekent." Als voorbeeld van een niche op het gebied van client computing die er wel baat bij heeft noemt Therien, workstations voor 3d-rendering, simulaties en 360-gradenvideo's.

Intel verbindt zelf overigens ook wel verschillende dies op een enkele processor. Het bedrijf heeft hoge verwachtingen van zijn emib, of embedded multi-die interconnect bridge. Het doel hiervan is niet om het aantal cores te verhogen, maar om verschillende chips zoals fpga's, x86-processors en geheugen, en verschillende productieprocedés op een enkele package te combineren. De eerste Core 2 Quad van Intel was ook een multi-chip-package met twee dies, met elk twee cores.

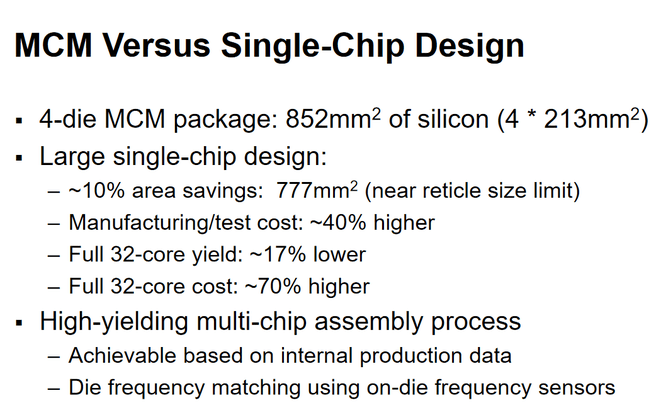

AMD's methode om verschillende dies met elkaar te koppelen, via de Infinity Fabric-interconnect, stelt het bedrijf in staat na lange tijd weer te concurreren op de servermarkt, waar Xeon-chips lange tijd heer en meester waren, en op de markt voor systemen die wel baat hebben bij veel cores. AMD kan dit doen op een schaalbare manier tegen relatief lage kosten en met minder risico op slechte yields. Zo kan AMD relatief eenvoudig overstappen op 7nm voor zijn Epyc-processors met mogelijk meer dan de huidige maximale 32 cores.

/i/2002230817.jpeg?f=imagenormal)

:strip_icc():strip_exif()/i/2002280229.jpeg?f=fpa_thumb)

:strip_exif()/i/2002304455.jpeg?f=fpa)

:strip_exif()/i/2002281167.jpeg?f=fpa)

:strip_exif()/i/2002147681.jpeg?f=fpa)

/i/1242207182.png?f=fpa)

/i/1204897246.png?f=fpa)