Inleiding: opvoeren

Er gingen al geruime tijd geruchten over een nieuwe videokaart van AMD. De meest optimistische en weinig realistische hoop was een Navi-kaart op 7nm, maar naarmate meer details bekend werden, zoals de naam van de kaart, kwam een realistischer beeld naar voren. Volgens een van die realistischere geruchten, of wensen zo je wilt, zou de RX 590 een kaart met een Polaris-architectuur worden, maar dan geoptimaliseerd, die zuiniger zou zijn en bovendien meer streamprocessors zou bevatten.

Die geruchten blijken ten dele waar. Nee, de RX 590 heeft niet meer streamprocessors gekregen dan de RX 580; het zijn er nog steeds 2304, verdeeld over 36 compute-units. De RX 590-gpu wordt op het verbeterde 12nm-procedé gebakken en heeft de vierde generatie GCN-architechuur aan boord. Dat zou een snellere en zuinigere gpu opleveren, maar of dat lukt moet nog blijken. Gezien de identieke chipafmetingen van 232 vierkante millimeter als de 580 lijkt het 12nm-procedé vooral een finfet-optimalisatie en geen die-shrink, net als we bij Zen en Zen+ zagen.

AMD heeft echter wel kans gezien om de kloksnelheden van de RX 590-gpu flink op te schroeven. Waar de clocks van de RX 580 stock nog op 1257MHz met een boost naar 1340MHz tikken, is dat bij de RX 590 opgekrikt naar respectievelijk 1469 en 1545MHz.

| |

RX 590 |

RX 580 |

GTX 1060 |

GTX 1070 |

| Codenaam |

Polaris 30 (12nm) |

Polaris 20 (14nm) |

Pascal GP106 (16nm) |

Pascal GP104 (16nm) |

| Compute units |

36 |

36 |

10 |

15 |

| Streamprocessors / cuda cores |

2304 |

2304 |

1280 |

1920 |

| Kloksnelheid/boost |

1469/1545MHz |

1257/1340MHz |

1506/1708MHz |

1506/1683MHz |

| Rekenkracht (fp32) |

7,1Tflops |

6,2Tflops |

4,4Tflops |

6,5Tflops |

| Geheugengrootte |

8GB gddr5 |

8GB gddr5 |

6GB gddr5 |

8GB gddr5 |

| Geheugenbus |

256bit |

256bit |

192bit |

256bit |

| Geheugenbandbreedte |

256GB/s |

256GB/s |

192GB/s |

256GB/s |

| Geheugenkloksnelheid |

2000MHz |

2000MHz |

2000MHz |

2000MHz |

| Texture units |

144 |

144 |

80 |

120 |

| Board power |

225W |

185W |

120W |

150W |

De overige specificaties zijn nog onveranderd; er is 8GB gddr5-geheugen beschikbaar, dat over een 256bit brede bus wordt aangesproken, goed voor een geheugenbandbreedte van 256GB/s. AMD heeft de kaart dan ook vooral ontwikkeld om het prestatiegat tussen de RX 580 en de Vega-kaarten op te vullen, zonder een heel dure kaart in dat segment te brengen.

De adviesprijs van de kaart bedraagt dan ook 279 dollar en onder meer Asus, Sapphire, XFX en Powercolor moeten kaarten bij introductie beschikbaar hebben. AMD positioneert de RX 590 vooral als mainstreamgamingkaart, voor 1080p-schermen, liefst met AMD's Freesync-technologie. We gaan kijken hoe deze mainstreamkaart presteert.

Testmethode

Van AMD ontvingen we een Powercolor Red Devil RX590, een Sapphire Nitro+ Special Edition en een Black Edition-kaart van XFX. We hebben de kaarten op standaardkloksnelheden ingesteld en als referencemodel getest. De gebruikte driver daarvoor, en voor de overige AMD-kaarten, is 18.6.11 en voor de Nvidia-kaarten hebben we versie 398.11 gebruikt. We hebben getest op een X299-moederbord met Intels Core i9-7900X op 4,5GHz en met 16GB geheugen.

| |

Testsysteem |

| Moederbord |

Asus Strix X299-E Gaming |

| Processor |

Intel Core i9-7900X @ 4,5GHz |

| Geheugen |

G.Skill Trident Z 32GB DDR4-3200 CL14 |

| Ssd |

2x Samsung 850 Evo 1TB |

| Voeding |

Superflower Leadex 1600W Platinum |

| Behuizing |

CoolerMaster Test Bench |

| Besturingssysteem |

Windows 10 Pro |

We testen de onderstaande games op drie resoluties: 1080p, 1440p en 4k. Dat doen we met medium- en ultra-instellingen. Voor de RX590 zijn vooral de 1080p-benchmarks relevant; 4k is met deze kaart weinig zinvol, zeker op hoge settings. Verder draaien we de synthetische benchmarks 3DMark en Unigine Superposition. Ten slotte testen we de geluidsproductie idle en onder load op 10cm afstand van de kaart en meten we het opgenomen vermogen van de videokaart onder load en idle.

| Games |

Verschijningsdatum |

DirectX-versie |

Engine |

| Assassin's Creed: Origins |

Oktober 2017 |

DX11 |

Anvil Next 2.0 |

| Battlefield 1 |

Oktober 2016 |

DX12 |

Frostbite |

| F1 2018 |

Augustus 2018 |

DX11 |

EGO Engine 4.0 |

| Far Cry 5 |

Maart 2018 |

DX11 |

Dunia |

| Forza Motorsport 7 |

Oktober 2017 |

DX12 |

Forza Tech |

| Ghost Recon: Wildlands |

Maart 2017 |

DX11 |

Anvil Next |

| GTA V |

April 2015 |

DX11 |

Rage |

| Rise of the Tomb Raider |

Januari 2016 |

DX12 |

Foundation |

| Total War Warhammer II |

September 2017 |

DX12 |

Warscape |

| The Witcher 3: Blood and Wine |

Mei 2015 |

DX11 |

Red Engine 3 |

| Wolfenstein II: The New Colossus |

Oktober 2017 |

Vulkan |

Id Tech 6 |

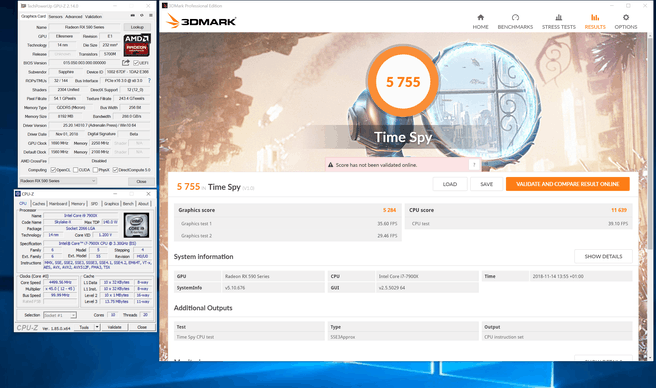

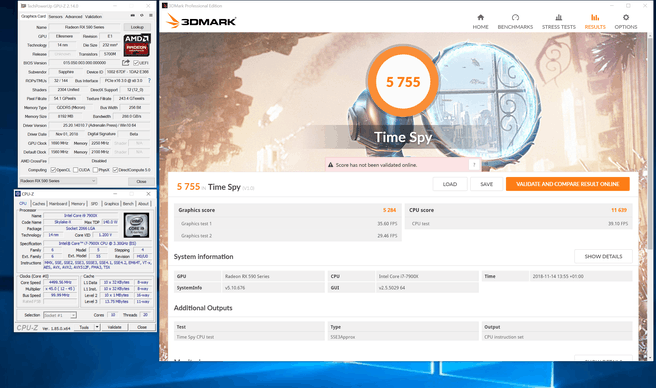

Synthetische benchmarks

We beginnen met 3DMarks Fire Strike en Time Spy, en Superposition van Unigine. Fire Strike is een DX11-benchmark, terwijl Time Spy een DX12-benchmark is. Superposition is een zware benchmark die ook een 4k-versie heeft. We draaien Superposition in 1080p en in 4k.

Fire Strike

- 3DMark Fire Strike (graphics)

- 3DMark Fire Strike Extreme (totaal)

- Fire Strike Ultra

Time Spy

Superposition

- Unigine Superposition - 1080p - High

- Unigine Superposition - 4k - Optimized

De RX 590 is steeds acht tot tien procent sneller dan de RX 580, maar de 1070 is uiteraard stukken sneller.

Assassin's Creed: Origins

We gaan verder met games. We publiceren alle resultaten, maar 4k-gaming is met deze kaart natuurlijk wat optimistisch; we richten ons voornamelijk op 1080p-gaming.

- AC: Origins 1080p - Medium

- AC: Origins 1080p - Ultra

- AC: Origins 1440p - Medium

- AC: Origins 1440p - Ultra

- AC: Origins 4k - Medium

- AC: Origins - 4k - Ultra

In Assassin's Creed is de RX590 maar marginaal sneller dan de 580, zeker als de details worden opgeschroefd. Op 1080p is de game goed te spelen met aardige framerates, hoewel we met de ultra-preset al onder de 60fps duiken. Op hogere resoluties zitten we op medium al onder de 60fps en bij 4k halen we de 30fps ternauwernood.

Battlefield 1

- Battlefield 1 DX12 - 1080p - Medium

- Battlefield 1 DX12 - 1080p - Ultra

- Battlefield 1 DX12 - 1440p - Medium

- Battlefield 1 DX12 - 1440p - Ultra

- Battlefield 1 DX12 - 4k - Medium

- Battlefield 1 DX12 - 4k - Ultra

Op 1080p met medium-settings is de 590 in Battlefield bijna net zo snel als de 1070, maar op ultra loopt die laatste flink uit. Datzelfde beeld zien we op 1440p en pas op 4k zakken we onder de 60fps met de kaarten.

F1 2018

- F1 2018 - 1080p - Medium

- F1 2018 - 1080p - Ultra

- F1 2018 - 1440p - Medium

- F1 2018 - 1440p - Ultra

- F1 2018 - 4k - Medium

- F1 2018 - 4k - Ultra

In F1 2018 is de RX590 weer een paar procent sneller dan de RX580 op de medium-preset in 1080p en 1440p. In 4k is het verschil wat groter en ook als we de preset op ultra zetten, is de 590 een stuk sneller dan de 580. Overigens is 4k-gaming op medium nog net te doen met de 590 in F1, maar ultra is een brug te ver.

Far Cry 5

- Far Cry 5 - 1080p - Normal

- Far Cry 5 - 1080p - Ultra

- Far Cry 5 - 1440p - Normal

- Far Cry 5 - 1440p - Ultra

- Far Cry 5 - 4k - Normal

- Far Cry 5 - 4k - Ultra

In Far Cry 5 is de RX590 een gezonde tien procent sneller dan de 580 op normal-detail, maar op ultra wordt het verschil wat kleiner. Aan de framerates van de 1070 kan de kaart niet tippen, maar de 1060 wordt weer op alle vlakken verslagen.

Forza Motorsport 7

- Forza 7 - 1080p - Medium

- Forza 7 - 1080p - Ultra

- Forza 7 - 1440p - Medium

- Forza 7 - 2560x1440 - Ultra

- Forza 7 - 4k - Medium

- Forza 7 - 4k - Ultra

In Forza zien we vaker afwijkende resultaten en dat is hier niet anders; de RX590 is in 1080p en 1440p met medium-preset de snelste kaart en de 1070 van Nvidia wordt ruim voorbijgestreefd. Op ultra-settings zijn beide Nvidia-kaarten echter sneller en is de 590 alleen sneller dan de RX580. Forza op 4k met medium-settings is echter nog erg goed te doen, met framerates boven de 100fps.

Ghost Recon: Wildlands

- Ghost Recon Wildlands - 1080p - Medium

- Ghost Recon Wildlands - 1080p - Ultra

- Ghost Recon Wildlands - 1440p - Medium

- Ghost Recon Wildlands - 1440p - Ultra

- Ghost Recon Wildlands - 4k - Medium

- Ghost Recon Wildlands - 4k - Ultra

In Wildlands is de RX590 zes tot negen procent sneller dan de RX580 in de drie geteste resoluties, maar maar het verschil met de 1070 bedraagt steeds zo'n twintig procent. De 1060 zit steeds op het niveau van de RX580.

GTA V

- GTA V - 1080p - Medium

- GTA V - 1080p - Ultra

- GTA V - 1440p - Medium

- GTA V - 1440p - Ultra

- GTA V - 4k - Medium

- GTA V - 4k - Ultra

Voor GTA 5 kun je beter een Geforce-kaart kopen, want niet alleen de 1070 is flink sneller dan de RX590, ook de 1060 is stukken sneller. De 590 is wel veel sneller dan de 580.

Rise of the Tomb Raider

- Rise of the Tomb Raider - 1080p - Medium

- Rise of the Tomb Raider - 1080p - Ultra

- Rise of the Tomb Raider - 1440p - Medium

- Rise of the Tomb Raider - 1440p - Ultra

- Rise of the Tomb Raider - 4k - Medium

- Rise of the Tomb Raider - 4k - Ultra

De RX590 is steeds tien procent sneller in Tomb Raider dan de RX580, ongeacht de resolutie of kwaliteit. De achterstand op de 1070 is minstens zo groot als de voorsprong op de 580 en de 1060 wordt door alle kaarten achtergelaten. Tomb Raider is tot 1440p speelbaar met de RX590; 4k is te hoog gegrepen.

Total War Warhammer II

- Total War: Warhammer II - 1080p - Medium

- Total War: Warhammer II - 1080p - Ultra

- Total War: Warhammer II - 1440p - Medium

- Total War: Warhammer II - 1440p - Ultra

- Total War: Warhammer II - 4k - Medium

- Total War: Warhammer II - 4k - Ultra

In Warhammer zien we een kleine winst van de 590 ten opzichte van de 580. Daarbij is 1440p op medium-instellingen wel het maximaal haalbare met de nieuwe kaart. De 1070 is overal een stuk sneller, maar haalt ook geen speelbare framerates op 1440p met ultra-preset.

The Witcher 3: Blood and Wine

- The Witcher 3 B&W - 1080p - Medium

- The Witcher 3 B&W - 1080p - Ultra

- The Witcher 3 B&W - 1440p - Medium

- The Witcher 3 B&W - 1440p - Ultra

- The Witcher 3 B&W - 4k - Medium

- The Witcher 3 B&W - 4k - Ultra

In The Witcher is de 590 steeds een procent of tien sneller dan de 580, waarbij 1440p op medium weer de maximale resolutie voor dit segment is.

Wolfenstein II: The New Colossus

- Wolfenstein II - 1080p - Medium

- Wolfenstein II - 1080p - Ultra

- Wolfenstein II - 1440p - Medium

- Wolfenstein II - 1440p - Ultra

- Wolfenstein II - 4k - Medium

- Wolfenstein II - 4k - Ultra

In Wolfenstein II ten slotte scoren de 580 en 590 in alle tests vrijwel identiek. De 1070 is een stuk rapper in alle tests, met een voorsprong tot ruim 25 procent.

Opgenomen vermogen en overklokken

We meten het vermogen van de videokaarten met behulp van een riserkaart tussen het pcie-slot en de kaart, en natuurlijk door de peg-connectors af te tappen, volledig geïsoleerd van de rest van het systeem. Zo meten we enkel de videokaart en niet het opgenomen vermogen van het complete systeem. Dat moet een beter beeld opleveren van de tdp's van de kaarten.

De Nvidia-kaarten zijn zowel idle als onder belasting tijdens het gamen een stuk zuiniger dan AMD's aanbod. Het gat tussen de 580 en de 1060 en 1070 is al groot, maar om de hogere clocks mogelijk te maken, is de 590 nog een stuk minder zuinig.

Overklokken

We hebben de Sapphire-kaart overgeklokt en daarbij kon de gpu stabiel op 1690MHz tikken. Daarvoor was in Afterburner een extra spanning van 100mV nodig. Dat leverde een Time Spy-score van 5755 punten op, een bijna negen procent hoger dan de 5300 punten van de stock kaart. Het geheugen tikte daarbij op 2250MHz in plaats van de stock 2100MHz.

- F1 2018 - 1080p - Medium

- F1 2018 - 1080p - Ultra

We hebben F1 ook nog even gedraaid op 1080p Medium en Ultra en delen die resultaten even. De overgeklokte kaart komt iets beter in de buurt van de 1070, maar helemaal inhalen lukt niet.

Conclusie

Na de introductie van de Vega-kaarten, niet 's werelds succesvolste videokaartintroductie, is het een tijd stil geweest rond AMD's Radeon-divisie. Het wachten is op de nieuwe generatie kaarten met de Navi-architectuur aan boord, maar dat gaat nog wel even duren. Om toch iets nieuws, en dat woord gebruiken we in ruime zin, in het lagere middensegment te bieden, heeft AMD de RX 590 uitgebracht.

Feitelijk is de 590 weinig meer dan een opgevoerde 580, maar of dat heel erg is, mag je zelf beslissen. Het opkrikken van de kloksnelheid heeft twee effecten. Enerzijds is de kaart een stukje sneller dan de 580; door de bank genomen schelen de twee kaarten zo'n acht procent op alle resoluties met medium-settings, en 7 procent op de ultra-settings. De hogere clocks brengen wel een hoger verbruik met zich mee en als we naar de concurrentie kijken, was een lager verbruik juist bijzonder welkom geweest.

En over concurrentie gesproken: het is wat onduidelijk waartegenover AMD de 590 nu positioneert. De 580 was al sneller dan de 1060 en aan de 1070 kon de 580 niet tippen. De 590 kan dat, ondanks de betere prestaties, nog steeds niet, en zit een beetje alleen tussen de instappers en het echte middensegment. Wat dat betreft is het wel een interessante kaart, maar het blijft een echte 1080p-kaart, hoewel je met conservatieve instellingen ook wel 1440p kunt spelen.

Zoals gebruikelijk komt het weer neer op prijzen. Als AMD de prijzen schappelijk houdt, en inderdaad ruim onder de 300 euro blijft, dan is het een leuke kaart. Als de straatprijs van 590-kaarten echter boven die 300 euro uitstijgt, kom je aardig in de buurt van een 1070, die vanaf 380 euro verkrijgbaar is en stukken sneller is. Kortom, als 580-alternatief en 1060-concurrent moet de 590 onder de 300 euro blijven om interessant te zijn.

:strip_icc():strip_exif()/i/2002492352.jpeg?f=fpa_thumb)

:strip_exif()/i/2000957445.jpeg?f=fpa)

:strip_exif()/i/2002306299.jpeg?f=fpa)

/i/2001237765.png?f=fpa)

:strip_exif()/i/1380099265.jpeg?f=fpa)