Nvidia heeft de GeForce GTX Titan Z, waarvan enkele details eerder al uitlekten, officieel aangekondigd. De monstervideokaart herbergt twee gpu's met in totaal 5760 cores die het grafische werk op zich nemen.

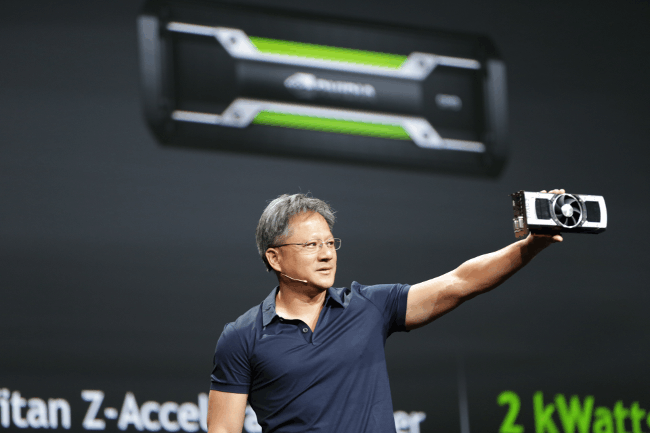

De GeForce GTX Titan Z werd door Nvidia-ceo Jen-Hsun Huang getoond op een eigen conferentie van Nvidia. Het bakbeest heeft twee GK110-gpu's aan boord die elk kunnen rekenen met 2880 cores, oftewel 5760 cores in totaal. Ook is 12 gigabyte aan geheugen aanwezig. De rekencapaciteit van de kaart bedraagt 8 teraflops.

Volgens Nvidia is de kaart geschikt voor het spelen van games op een 5k-resolutie of meer dan één monitor. Bovendien wordt het apparaat niet warm tijdens gebruik en is de kaart relatief stil, stelt het bedrijf. Wanneer de GeForce GTX Titan Z in de winkel ligt, is onduidelijk, maar zeker is wel dat er flink wat voor moet worden neergeteld; de adviesprijs in de Verenigde Staten bedraagt 3000 dollar.

Tijdens de conferentie toonde Nvidia ook een nieuwe gpu-interface aan de wereld. NVLink, zoals de nieuwe interface heet, moet pci-express 3.0 vervangen en vijf tot twaalf keer zo snel zijn als pci-express 3.0. De GeForce GTX Titan Z is voor zover bekend nog niet van de interface voorzien.

:strip_exif()/i/1395779925.png?f=thumbmedium)

/i/2000584654.png?f=fpa)

/i/1208164214.png?f=fpa)

/i/1397132571.png?f=fpa)

/i/1301328808.png?f=fpa)

:strip_exif()/i/1371172691.jpeg?f=fpa)