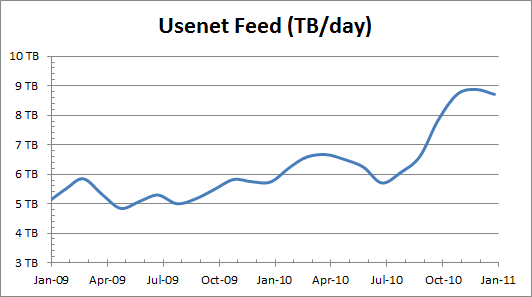

Usenetaanbieder Giganews laat weten dat de hoeveelheid data die dagelijks door de klanten van het bedrijf wordt gepost, in twee jaar tijd bijna is verdubbeld. De provider verwerkt nu bijna 9 terabyte per dag.

![]() Giganews, een van de grootste usenetproviders ter wereld, laat in een grafiek zien dat de hoeveelheid geposte data tussen januari 2009 en januari van dit jaar is gestegen van circa 5TB tot bijna 9TB per dag.

Giganews, een van de grootste usenetproviders ter wereld, laat in een grafiek zien dat de hoeveelheid geposte data tussen januari 2009 en januari van dit jaar is gestegen van circa 5TB tot bijna 9TB per dag.

De usenetprovider, die in Nederland aan diverse wederverkopers zijn diensten aanbiedt en een serverpark aan de AMS-IX heeft gekoppeld, stelt dat hoofdoorzaak van de groei simpelweg het toenemende gebruik van nieuwsgroepen is. Ook in Nederland is usenet populairder geworden, mede dankzij eenvoudiger tools om binaries uit de nieuwsgroepen te plukken, de hogere downloadsnelheden ten opzichte van p2p-netwerken en het bestaan van communities als FTD.

Giganews laat ook weten dat het de retentieperiode heeft opgetrokken naar 900 dagen. Dat betekent dat postings in nieuwsgroepen circa 2,5 jaar bewaard blijven op de servers van de usenetaanbieder. Het oude plafond van Giganews stond op 700 dagen retentie.

Update, 10:38: het artikel is herschreven om duidelijker te maken dat het alleen om het postverkeer bij Giganews gaat en niet om het downloadverkeer.

/i/1296030738.png?f=fpa)

/i/1195461505.png?f=fpa)

/i/1285849102.png?f=fpa)

/i/1239296169.png?f=fpa)

/i/1117106632.png?f=fpa)