Nanochip werkt aan een geheugenchip met een capaciteit van 100GB. De chip zou met verouderde apparatuur te maken zijn en in de toekomst een terabyte moeten herbergen. Intel heeft in de techniek geïnvesteerd.

De halfgeleiderfabrikant heeft een investering van veertien miljoen dollar binnengehaald om geheugenchips met een capaciteit van honderd gigabyte te ontwikkelen. De investeerders, Intel Capital en JK&B Capital, vertrouwen erop dat Nanochip nog dit jaar de eerste prototypes zal leveren, waarbij de eerste consumentenversie voor 2009 in de planning staat. De gebruikte techniek is bijna tien jaar oud en voor de productie kan dan ook 'oude' apparatuur gebruikt worden, waardoor de fabricagekosten en investeringen ook bij toekomstige generaties chips laag kunnen blijven. Bovendien zou het geheugenchipontwerp tot één terabyte schaalbaar zijn en zouden de kosten lager liggen dan bij de productie van flashgeheugen.

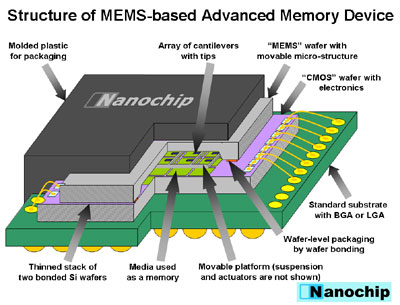

De chip is gebaseerd op een mems-ontwerp van IBM, de Millipede. In het originele ontwerp werden probes gebruikt die door middel van warmte putjes in het opnamesubstraat maakten. In het nieuwe ontwerp wil Nanochip polarisatie van het substraat in plaats van warmte toepassen. Door een matrix van 'naalden' te gebruiken die over een substraat beweegt om te lezen en schrijven, kan de chip niet alleen hoge datadichtheden, maar ook hoge lees- en schrijfsnelheden realiseren. In de huidige ontwikkelfase neemt een bit 15nm bij 15nm ruimte in beslag; in de toekomst moet 2nm of 3nm volstaan. Over de daadwerkelijke lees- en schrijfsnelheden heeft het bedrijf geen concrete gegevens losgelaten, evenmin zijn gegevens over duurzaamheid bekend. De door Nanochip voorgestelde geheugenchip zou bestaan uit twee delen: een chip met het te beschrijven substraat en een chip met de mems-naalden voor het lezen en schrijven.

/i/1201865680.png?f=fpa)