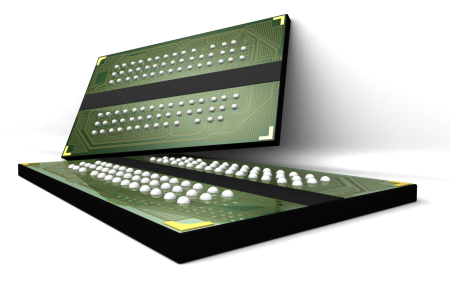

Micron heeft vandaag de Aspen-geheugenlijn aangekondigd. Het low-voltage ddr2-dram-geheugen kan het energieverbruik van datacenters met vierentwintig procent terugbrengen, claimt het bedrijf.

Ddr2-dram-chips in datacenters opereren momenteel meestal op 1,8 volt. De Aspen-lijn van Micron heeft echter genoeg aan 1,5 volt, wat een aanzienlijke energiebesparing voor datacenters op kan leveren. De servers van deze faciliteiten slurpten in 2005 wereldwijd 123 miljard kilowattuur, schatte het Lawrence Berkeley National Laboratory begin dit jaar. Volgens Micron neemt geheugen hierbij 25 miljard kilowattuur voor zijn rekening. Door over te stappen van 512-megabitmodules naar de nieuwe Aspen 1 gigabit reduced chip count modules zouden datacenters dit verbruik zelfs met de helft kunnen verminderen. Of de geheugenmodules aan gaan slaan is echter twijfelachtig. Ten eerste voldoet de Aspen-serie niet aan de Jedec-standaard voor solidstategeheugen; die schrijft namelijk minimaal 1,8 volt voor. Ten tweede zijn er geen partijen die chipsets bouwen met ondersteuning voor het low-voltage dram-geheugen. Micron hoopt echter dat hier snel verandering in komt. Dat zal een van de redenen zijn dat het bedrijf zitting heeft genomen in het 'Green Grid'-consortium, het overlegorgaan dat streeft naar efficiënter stroomverbruik van datacenters.

:strip_exif()/i/1143116142.jpg?f=fpa)