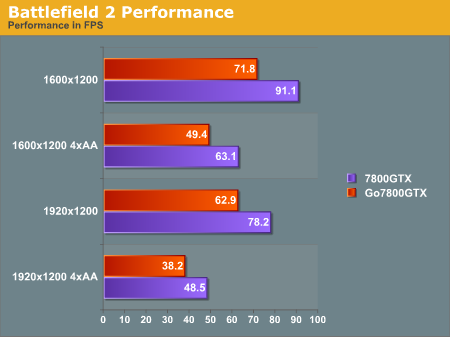

Bij AnandTech is een korte vergelijking verschenen tussen de GeForce Go 7800 GTX en zijn grote broer, de GeForce 7800 GTX. Qua specificaties zijn er weinig verschillen tussen beide kaarten, de mobiele variant heeft dezelfde features en evenveel pipelines als zijn grote broer. Het grote verschil is de kloksnelheid, bij de GeForce Go 7800 GTX zijn zowel de core als het geheugen circa tien procent lager geklokt. Uit de benchmarks blijkt dat dit verschil in kloksnelheid, niet geheel verrassend, ongeveer eenzelfde procentuele verschil in prestaties veroorzaakt. Hiermee is een notebook met GeForce Go 7800 GTX-kaart prima in staat om de meeste nieuwe games te draaien op 1920x1200 met anti-aliasing, een prima prestatie. Op het moment heeft ATi nog geen mobiele videokaart die deze prestatie kan evenaren en AnandTech vraagt zich af of hier in de nabije toekomst verandering in zal komen. De hoge kloksnelheid van de Radeon X1800 XT zorgt voor een hoog energieverbruik, iets dat moeilijk te combineren is met een notebook. Voor de ultieme mobiele gameprestaties zal men dus momenteel bij nVidia moeten aankloppen.