Op Beyond3D wordt gespeculeerd dat de G70-core van nVidia wel eens 32 pixel pipelines aan boord zou kunnen hebben, waarvan er in de GeForce 7800 GTX acht zijn uitgeschakeld. Dit zou voornamelijk gunstig zijn voor de yields van het product, want door meer pipelines op de chip te bakken dan er uiteindelijk verkocht worden kunnen exemplaren die af fabriek een of meerdere defecten hebben, gered worden van de vuilnisbak. Daarnaast levert deze truc een interessante mogelijkheid op voor een toekomstige (nog snellere) uitvoering van de van kaart. Op het moment dat er genoeg chips van de lopende band af komen rollen waarvan alle pipelines werken dan zouden die als een speciale editie van de GeForce 7800-serie verkocht kunnen worden. Op zich is deze theorie van Beyond3D niet zo heel vergezocht; ATi heeft immers precies hetzelfde gedaan met zijn R420.

De vraag is echter of het wel zou passen. De G70-core heeft namelijk 302 miljoen transistors aan boord, terwijl de NV40 er al 220 miljoen had. Hoeveel transistors er per pixel pipeline in beslag worden genomen is onbekend, maar een toename van 'slechts' 82 miljoen transistors lijkt op het eerste gezicht te weinig voor zestien extra pipelines. Een schatting die gebaseerd is op het verschil tussen de NV40 en de NV43, levert namelijk toch wel tussen de 5 en 8 miljoen transistors per pipeline op. Zonder grote wijzigingen zou het dus erg onwaarschijnlijk (zo niet onmogelijk) zijn dat de G70 eigenlijk 32 pixel pipelines aan boord heeft.

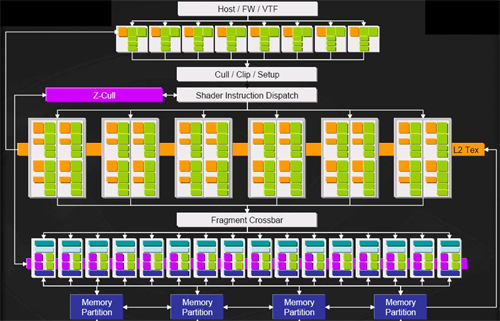

Het grote punt is alleen dat die wijzigingen er wel degelijk zijn. Sowieso heeft nVidia enkele onderdelen van de pipeline opnieuw ontworpen, maar er is in de G70 ook een splitsing gemaakt in de traditionele pixel pipeline. Tot en met de NV45 bestond iedere pixel pipeline bij nVidia uit twee onderdelen: een fragment shader en een render output unit. Een videokaart met 16 pipelines had dus altijd 16 fragment shaders en 16 render output units aan boord. Met de komst van de GeForce 7800 GTX gaat die regel niet meer op: deze kaart heeft officieel 24 pipelines, maar daarmee wordt nu alleen bedoeld dat er 24 fragment shaders zijn; het aantal render output units is nog steeds 16 gebleven. Het idee hierachter is dat de kracht die nodig is op het gebied van shaders veel groter is dan de behoefte aan 'domme' fillrate, en dat extra render output units de moeite niet meer waard zijn. De transistors die bespaard worden door acht render output units weg te laten zouden echter wel eens precies genoeg kunnen zijn om acht extra fragment shaders kwijt te kunnen.

:strip_exif()/i/1132684024.jpg?f=thumbmedium)