Tom's Hardware heeft acht verschillende RAID-controller uitbreidingskaarten met elkaar vergeleken. Vijf daarvan, te weten de Adaptec ATA Raid 1200A, de Dawicontrol DC-100 Raid, de Dawicontrol DC-133 Raid, de Highpoint Rocket Raid 133, en de Highpoint Rocket Raid 404 zijn voorzien van twee kanalen voor de aansluiting van vier harddisks. De 3Ware Escalade 7850, de Highpoint Rocket Raid 404, en de Megaraid i4 van LSI Logic zijn vierkanaals en kunnen acht harddisks bedienen. Na de diverse tests wijst THG twee kaartjes als aanbevelenswaardig aan:

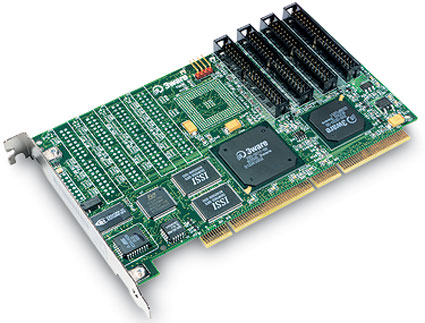

3Ware Escalade 7850

Based on the strength of its good performance and features, the "Editor's Choice" goes to the 3Ware Escalade 7850. It is even easy to use. The technical performance of this high-end card makes it particularly suited for use in entry-level servers.

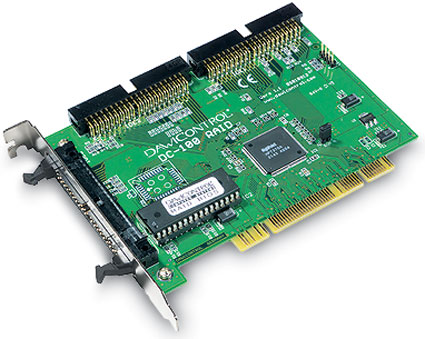

Dawicontrol DC-100 Raid

The DC-100 delivered convincing benchmark scores and service support. With a five-year manufacturer's warranty including exchange service, the DC-100 is our "Budget Recommendation."

:strip_exif()/i/1000417684.jpg?f=thumbmedium)

:strip_exif()/i/1018855794.jpg?f=thumbmedium)

:strip_exif()/i/1032174806.gif?f=fpa)